Nvidia ha desarrollado una versión de su GPU H100 específicamente para el modelo de lenguaje grande y el desarrollo de IA generativa.

El H100 NVL de doble GPU tiene más memoria que el H100 SXM o PCIe, así como más ancho de banda de memoria, características clave para los grandes modelos de IA.

El H100 existente viene con 80 GB de memoria (HBM3 para SXM, HBM2e para PCIe). Con la NVL, ambas GPU se empaquetan en 94 GB, para un total de 188 GB HBM3.

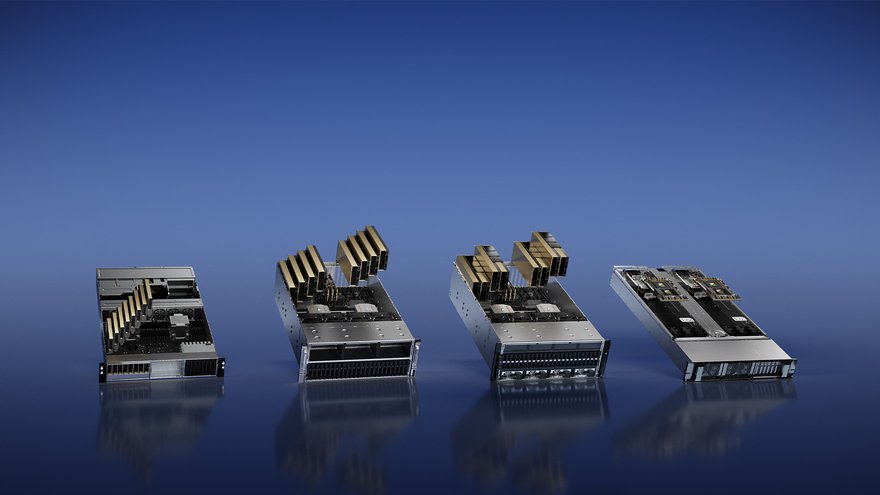

También tiene un ancho de banda de memoria de 3,9 TBps por GPU, para un total combinado de 7,8 TBps. A modo de comparación, el H100 PCIe tiene 2 TBps, mientras que el H100 SXM tiene 3,35 TBps. El nuevo producto tiene tres conectores NVLink en la parte superior.

Cada GPU también consume alrededor de 50 W más que el H100 PCIe y se espera que use 350-400 W por GPU.

En comparación con la GPU A100 que utilizó OpenAI para desarrollar GPT-3, Nvidia afirma que ofrece un rendimiento de inferencia hasta 12 veces más rápido.

"Esta increíble GPU reducirá considerablemente el costo total de propiedad (TCO) para ejecutar y realizar inferencias en modelos de lenguaje grande y basados en GPT", dijo Ian Buck, vicepresidente de hiperescala y HPC de Nvidia. "Jugará un papel crucial en la democratización de GPT y grandes modelos de lenguaje para un uso generalizado".