Nvidia ha anunciado una nueva clase DGX, la GH200, para cargas de trabajo de IA generativa.

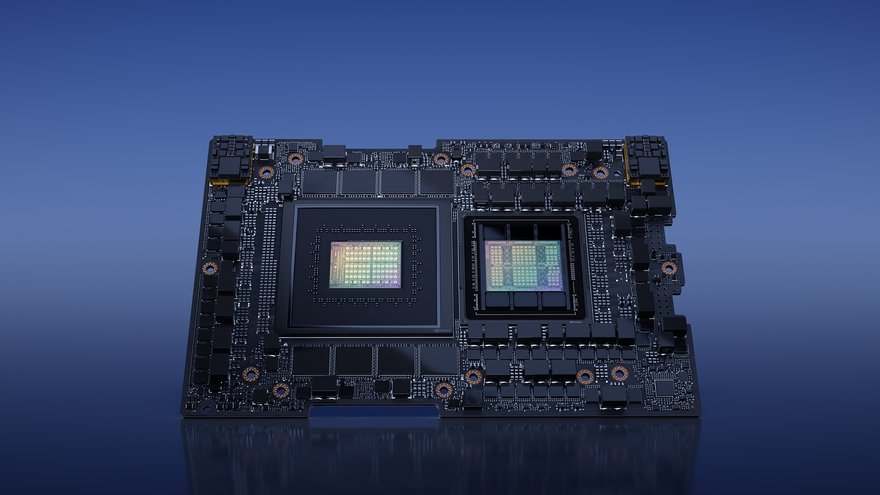

El DGX GH200 conecta hasta 256 Superchips Grace Hopper en un único sistema de GPU de 144 TB. El superchip es en sí mismo una combinación de la CPU Grace Arm de Nvidia y la GPU Hopper, conectadas por la interconexión de chip a chip NVLink C2C. Esos superchips se conectan luego mediante la nueva interconexión del sistema de interruptores NVLink.

Juntos, los 256 superchips tienen 144 terabytes de memoria compartida. El sistema también está disponible en variantes de 32, 64 y 128 chips.

Además, Nvidia planea poner en marcha una nueva supercomputadora, la Helios, con cuatro DGX GH200 con todas las especificaciones, para un total de 1,024 Superchips Grace Hopper.

Nvidia dijo que Google Cloud, Meta y Microsoft estarían entre los que obtendrán acceso al DGX GH200 para explorar sus capacidades para cargas de trabajo generativas de IA.

“La creación de modelos generativos avanzados requiere enfoques innovadores para la infraestructura de IA”, dijo Mark Lohmeyer, vicepresidente de Cómputo en Google Cloud.

“La nueva escala NVLink y la memoria compartida de Grace Hopper Superchips abordan los cuellos de botella clave en la IA a gran escala y esperamos explorar sus capacidades para Google Cloud y nuestras iniciativas de IA generativa”.

Las implementaciones tradicionales de DGX han emparejado dos CPU x86 con ocho GPU, pero este sistema tiene una proporción de 1:1. "Lo que trae, más allá de la huella de memoria que es masiva, es mucha más capacidad de procesamiento", dijo a DCD el vicepresidente y gerente general de DGX Systems de Nvidia, Charlie Boyle.

"En una canalización de IA, hay partes que son operaciones de GPU altamente paralelizadas, pero aún así siempre hay partes, ya sea parte de la preparación de datos o la transformación de imágenes, cosas para las que también puede necesitar recursos de CPU. Y así tener muy CPU fuerte, conectada directamente a la GPU, a) mejora el procesamiento, pero b) significa que algunas cosas en proceso, que tal vez antes tenía que hacer en diferentes sistemas, ahora puede permanecer en una arquitectura de sistema consistente y puede hacer todo tubería en él".

Girish Bablani, vicepresidente corporativo de Azure Infrastructure en Microsoft, agregó: “Entrenar grandes modelos de IA es tradicionalmente una tarea que requiere muchos recursos y tiempo. El potencial de DGX GH200 para trabajar con conjuntos de datos del tamaño de un terabyte permitiría a los desarrolladores realizar investigaciones avanzadas a mayor escala y velocidades aceleradas”.

A pesar de la computación de alta densidad, Boyle le dijo a DCD que el GH200 todavía está completamente enfriado por aire. "Esa fue una gran consideración en el diseño del sistema al hablar con nuestros clientes", dijo. "Sabemos que la gente tendrá en algún momento que cambiarse a líquido, pero también escuchamos comentarios de los clientes que dicen que eso es un desafío. Para ellos, sus centros de datos no están allí, necesitan construir nuevos centros de datos".

Boyle agregó: "Incluso obtener equipos refrigerados por líquido, porque nos mantenemos a la vanguardia, construyendo nuestras propias cosas internamente que tienen refrigeración líquida para que podamos probarlo para nuestros clientes, incluso obteniendo piezas líquidas, el tiempo de entrega es incluso mucho más largo.

Otra solicitud de los clientes fue que el sistema se pudiera utilizar de inmediato. Boyle reveló que Nvidia ahora usará una instalación de integración para probar completamente todo y configurarlo para que esté listo para usar tan pronto como se instale.

Y agregó que los clientes están solicitando implementaciones más grandes que nunca para respaldar las enormes demandas de la IA generativa. "La gente solía comprar un par de sistemas, probarlos y luego escalar una implementación", dijo Boyle. "[Ahora] mis equipos reciben llamadas de clientes que dicen: '¿Cuándo pueden entregarme cientos de sistemas?'"