IBM ha encendido una supercomputadora basada en la nube para su servicio de nube pública.

En una publicación de blog publicada esta semana, la compañía compartió detalles de Vela, una 'supercomputadora nativa de la nube optimizada para IA'.

El sistema ha estado en línea desde mayo de 2022, alojado en IBM Cloud. Actualmente, el sistema es solo para uso de investigadores de IA en IBM Research.

“Vela es ahora nuestro entorno de referencia para los investigadores de IBM que crean nuestras capacidades de IA más avanzadas, incluido nuestro trabajo en modelos básicos, y es donde colaboramos con socios para entrenar modelos de muchos tipos”, dijo la compañía.

La compañía señaló que ha elegido a Virtual Machines en lugar de bare metal para brindar una mayor flexibilidad y permitir a los investigadores aprovisionar y volver a aprovisionar la infraestructura con diferentes pilas de software según sea necesario.

La compañía dijo que ha ideado una forma de exponer todas las capacidades en el nodo (GPU, CPU, redes y almacenamiento) en la VM para que la sobrecarga de virtualización sea inferior al cinco por ciento, que dijo que era "la sobrecarga más baja en el industria'.

Cada nodo incluye ocho GPU Nvidia A100 de 80 GB, cada una con dos procesadores escalables Intel Xeon de segunda generación (Cascade Lake), 1,5 TB de DRAM y cuatro unidades NVMe de 3,2 TB. Los nodos están conectados en red a través de múltiples interfaces de red de 100G.

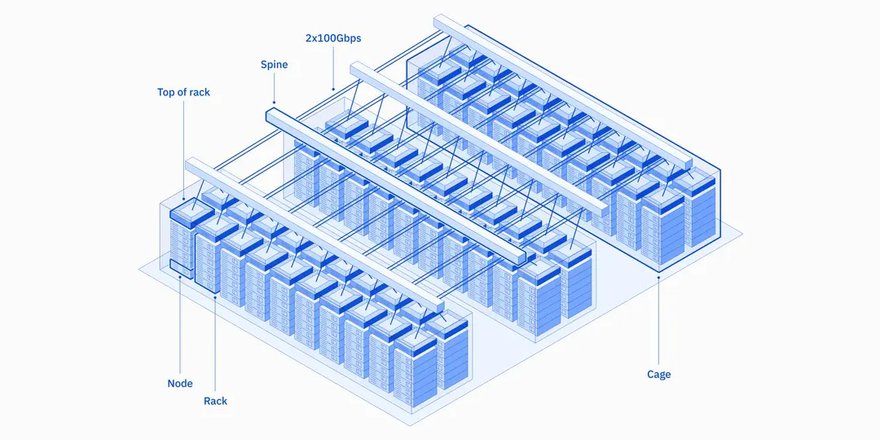

Un diagrama de la arquitectura de Vela sugiere que el sistema abarca 60 racks; una segunda publicación que presentaba algunas de las investigaciones de IA de la compañía describía un sistema con una configuración de nodo coincidente y una fecha de implementación que indicaba que el sistema tenía 200 nodos.

“Podemos usar eficientemente nuestras GPU en carreras de entrenamiento distribuidas con eficiencias de hasta el 90 por ciento y más para modelos con más de 10 mil millones de parámetros. A continuación, implementaremos una implementación de acceso directo a memoria remota (RDMA) a través de Ethernet convergente (RoCE) a escala y GPU Direct RDMA (GDR), para brindar los beneficios de rendimiento de RDMA y GDR y minimizar el impacto adverso en otro tráfico. Nuestras mediciones de laboratorio indican que esto reducirá la latencia a la mitad”, dijo la compañía.

Vela se integra de forma nativa en el entorno VPC de IBM Cloud, lo que significa que las cargas de trabajo de IA pueden utilizar cualquiera de los más de 200 servicios de IBM Cloud actualmente disponibles. Y aunque el trabajo se realizó en el contexto de una nube pública, IBM dijo que la arquitectura también podría adoptarse para el diseño del sistema de IA en las instalaciones.