Los operadores de centros de datos han aprendido a escudriñar sus edificios en busca de energía desperdiciada. Entienden que el camino hacia la eficiencia es seguir las lecciones básicas de la termodinámica: minimizar el esfuerzo invertido en eliminar el calor y, si es posible, evitar crearlo en primer lugar.

Saben que es genial ser "adiabático": evitar transferir calor al entorno. Y compiten para obtener cifras de PUE inferiores a 1,1, que es más del 90 por ciento de eficiencia en el suministro de energía a las computadoras.

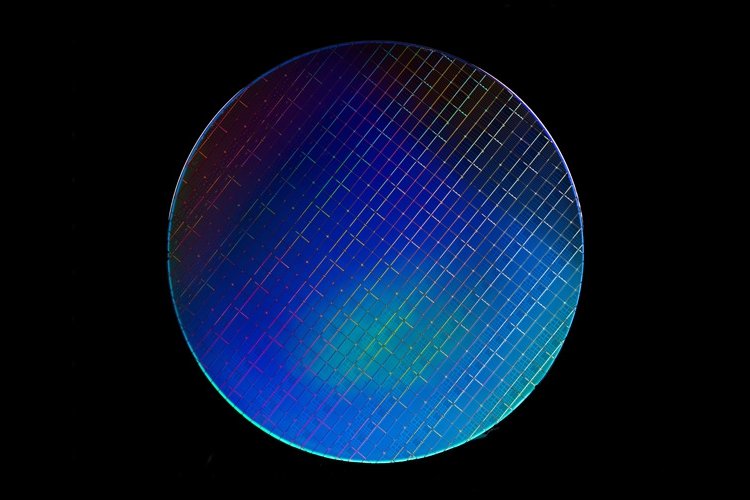

Pero los servidores en los racks están dejando el lado hacia abajo. Por impresionantes que sean sus procesadores, sus circuitos CMOS son en realidad mucho menos eficientes que las unidades CRAC y los transformadores de potencia con los que comparten un edificio. Y la tecnología está llegando a sus límites.

La industria de la tecnología de la información se ha apoyado triunfalmente sobre la base de la Ley de Moore: el hecho fenomenal de que cada dos años, el número de transistores en un chip se duplica ... durante más de cuarenta años. Esto proporcionó mejoras continuas en la potencia informática y la eficiencia energética, debido a la Ley de Koomey relacionada que dice que los requisitos de energía caerán al mismo ritmo.

Pero todos saben que esto está llegando a su fin. Los fabricantes de chips están luchando para que un proceso de 5 nm funcione, porque las puertas son tan pequeñas que hay un túnel cuántico a través de ellas.

De cara al futuro, podríamos usar alrededor de 100 attojulios (100 x 10-18J) por operación, según el profesor Jon Summers, quien dirige el Instituto de Investigación de Suecia (RISE), pero hay un límite teórico aún más bajo para la energía de cómputo que deriva del trabajo de Rolf Landauer de IBM en la década de 1960.

Computación reversible

Landauer observó que, incluso si todo lo demás en una computadora se hace de manera completamente eficiente, hay un costo de energía aparentemente ineludible. Siempre que hay una pérdida irreversible de información, como borrar un poco, la entropía aumenta y la energía convertida en calor. Se requiere una energía mínima fundamental para borrar un poco, y es minúscula: poco menos de 3 zeptojulios (3 x 10-21J) que es kBTln 2, donde kB es la constante de Boltzmann y T es la temperatura en kelvin. A los físicos les gusta usar electronvoltios (eV) para medir pequeñas cantidades de energía, pero incluso en esa escala es pequeña: 0.0175 eV.

“Sobre esa base, la computación es solo un 0.03 por ciento de eficiencia”, dijo Summers, una comparación impactante con eficiencias superiores al 95 por ciento para algunos de los equipos mecánicos y eléctricos con los que estas computadoras comparten un edificio.

¿Pueden las computadoras ponerse al día? En sus días de gloria, las leyes de Moore y Koomey proyectaban que podríamos alcanzar el límite de Landauer en 2050, pero Summers cree que eso nunca sucederá: "No se puede bajar a tres zetojulios debido a las fluctuaciones térmicas".

Pero si no puede reducir la energía requerida, su tecnología tiene limitaciones: cuando la miniaturiza, la densidad de potencia se dispara. La lógica bipolar transistor-transistor (TTL) se usó para las primeras computadoras y continuó en uso hasta el IBM 3081 de 1980, pero al ser miniaturizada, generaba tanto calor que necesitaba enfriamiento por agua.

La nueva tecnología CMOS reemplazó rápidamente a TTL en la década de 1980 porque usaba 100.000 veces menos energía, dijo Summers: "El flujo de calor disminuyó, la necesidad de refrigeración líquida desapareció y podrían seguir con la refrigeración por aire".

Ahora, a medida que el CMOS se ha reducido, la densidad de calor ha aumentado: "Hemos vuelto a subir esa curva, tres veces más que en TTL". El enfriamiento por agua está volviendo a estar de moda. Como antes, otras personas están buscando tecnologías alternativas. Y, como sucede, hay una línea de investigación que a menudo se pasa por alto y que podría reducir drásticamente la emisión de calor: eludiendo el límite de Landauer, pero cuestionando su suposición de que la informática implica la sobrescritura de datos.

Landauer asumió que en algún momento los datos debían borrarse, pero ¿y si eso no fuera cierto? Esa es una pregunta que Michael Frank, de los Laboratorios Nacionales Sandia de EE.UU., se ha estado haciendo durante más de 25 años: “Una computadora convencional pierde información todo el tiempo. Cada puerta lógica, en cada ciclo de reloj, sobrescribe destructivamente la salida anterior con la nueva salida. El principio de Landauer te dice, no importa cómo hagas esas operaciones, cualquier operación que sobrescriba la memoria tiene que disipar algo de energía. Eso es solo por la conexión entre la información y la entropía".

Yves Lecerf en 1963, y Charles Bennett en 1973, señalaron que la suposición de Landauer estaba equivocada. En teoría, una computadora no necesitaba borrar un poco, ya que la parte de borrado no era matemáticamente requerida.

En 1936, Alan Turing había demostrado que cualquier cálculo podía realizarse mediante un dispositivo escribiendo y borrando marcas en una cinta de papel, lo que llevó al modelo de programa almacenado seguido por todas las computadoras desde entonces. La máquina universal de Turing no era reversible, ya que lee y borra bits (Turing estaba pensando en otras cosas además de la entropía). Lecerf y Bennett demostraron que cualquier máquina universal de Turing podía ser reversible.

En la década de 1970, Richard Feynman hizo un seguimiento de esto, señalando que no hay un límite inferior para la energía requerida para un proceso reversible, por lo que, en principio, una computadora reversible podría brindarnos toda la computación que necesitamos sin consumir casi ninguna energía.

Sin embargo, Feynman señaló un gran inconveniente que se deriva de la física de estos sistemas. Para ser reversible o “adiabática”, una operación debe tener un equilibrio térmico. Para mantenerse en equilibrio térmico, esos procesos deben operar muy, muy lentamente. De modo que el sistema podría ser infinitamente eficiente, a costa de ser infinitamente lento.

Un pequeño número de físicos e informáticos han estado haciendo una lluvia de ideas durante años, buscando tecnologías reversibles que pudieran operar adiabáticamente o casi adiabáticamente, pero no tomándose un tiempo infinito para ello.

La teoría se encuentra con la realidad

En 1982, Edward Fredkin y Tomasso Toffoli del MIT diseñaron puertas lógicas reversibles, pero esto es teoría, así que las basaron en bolas de billar. A los físicos les gusta usar la mecánica clásica como modelo, y la pareja consideró un interruptor donde las esferas duras ingresaban a una caja física y tenían colisiones elásticas. Donde rebotaron comprendía la salida y, en teoría, el interruptor podría funcionar adiabáticamente en tiempo real.

El problema es que no se puede conseguir un sistema alineado de forma infinitamente precisa con cero fricción, como tampoco se puede eliminar el ruido térmico y los túneles en un sistema electrónico. Fredkin y Toffoli ofrecieron una alternativa electrónica, basada en condensadores e inductores, pero que necesitaba cero resistencia para funcionar.

Los investigadores comenzaron a trabajar en circuitos reversibles en CMOS, y los circuitos completamente reversibles comenzaron con Saed Younis trabajando en el grupo de Tom Knight en el MIT.

Al mismo tiempo, otros grupos diseñaron sistemas mecánicos, basados en varillas y palancas. Ralph Merkle, del Institute for Molecular Manufacturing, Palo Alto, diseñó máquinas a nanoescala completamente reversibles, basadas en pequeñas barras físicas en movimiento. Otros trabajaron en puntos cuánticos, sistemas que usan electrones individuales para manejar información, a temperaturas muy bajas.

Todos estos enfoques implican compensaciones. Pueden ser completamente reversibles, pero requerirían métodos de fabricación completamente nuevos, podrían involucrar mucho más espacio físico. Los sistemas de baja temperatura tienen un costo energético asociado y, como señaló Feynman, algunos sistemas reversibles funcionan muy lentamente.

Tal como están las cosas, la industria de TI ha elegido un camino que prioriza los resultados sobre la eficiencia. Eso no es nada nuevo. Los canales son increíblemente eficientes y permiten que los productos floten sin fricción, tirados por un caballo. Sin embargo, en el siglo XIX, la revolución industrial en Gran Bretaña eligió los ferrocarriles, impulsados por la quema de carbón, porque los ferrocarriles permitían el transporte a cualquier destino rápidamente.

La computación clásica reversible puede potencialmente ahorrar energía, resolviendo problemas generales convencionales: “Una buena analogía es la diferencia entre tirar basura y reciclar”, dijo Frank a DCD. “Es más fácil tirarlo al vertedero que transformarlo, pero en principio, podrías ahorrar”. Cuando sobrescribimos bits, dijo, dejamos que la información se convierta en entropía, lo que genera calor que debe ser sacado de la máquina.

“Si tiene información que ha generado y ya no la necesita, la forma reversible de tratarla es 'descomputarla' o deshacer las operaciones físicas que la calcularon. En general, puede tener una cinta adicional, donde graba temporalmente información que habría borrado y luego la descomputa más tarde". La informática es un poco como el frenado regenerativo en un vehículo: recuperando la energía que se ha puesto.

La informática eligió CMOS porque funciona, y desde que se hizo esa elección, la informática reversible ha sido ignorada por la investigación general. Como miembro del grupo del MIT en la década de 1990, Frank ayudó a crear algunos de los prototipos y demostraciones de los conceptos. Se ha mantenido fiel a su promesa desde entonces, defendiendo pacientemente su potencial, mientras observa que la inversión y el enfoque de los medios se dirigen a perspectivas más interesantes como la computación cuántica.

Desde 2015, como científico senior en Sandia National Laboratories, ha establecido la computación reversible como una posible dirección futura para TI. A través del IEEE, ha contribuido a la Hoja de ruta internacional para dispositivos y sistemas (IRDS), una serie de documentos que trazan los probables desarrollos en semiconductores, y la computación reversible está ahora en ese mapa.

Hay mucho entusiasmo por otras tecnologías en la lista, como la computación cuántica, que ofrece potencialmente grandes aumentos de velocidad utilizando superposiciones de estados cuánticos.

Google y otros están corriendo hacia la "supremacía cuántica", pero la cuántica puede tener límites, dijo Frank. “La computación cuántica ofrece aceleraciones de algoritmos. Se reduce a tipos específicos de problemas. Tiene mucha sobrecarga, con temperaturas muy bajas y sistemas masivos. El costo real por operación es enorme, y nunca ejecutará una hoja de cálculo".

Frank tiene claro las ventajas y desventajas de la informática reversible. Ahorrar bits ocupa espacio. “Es una compensación entre el costo y la eficiencia energética”, nos dijo, pero a medida que los chips se acercan a sus limitaciones actuales, ese espacio podría estar disponible.

Debido a que los chips de hoy generan tanto calor, el problema que Summers señaló anteriormente, a menudo están plagados de "silicio oscuro".

Los chips de hoy tienen más puertas de las que pueden usar a la vez. Se construyen como sistemas en un chip (SOC), que combinan diferentes módulos. Summers dijo: “Un chip multinúcleo puede tener un presupuesto de 100W. Para no exceder eso, solo se pueden encender tantos transistores ".

Los proveedores de silicio nos están dando puertas que no podemos usar todas a la vez. "Los fabricantes nos han engañado", dijo Summers.

Un paso a la vez

Frank cree que este silicio oscuro podría usarse para introducir algunos aspectos de la computación reversible. "Podríamos aprovechar más transistores que se pueden fabricar en un chip determinado, si los tenemos encendidos y haciendo las cosas adiabáticamente". El espacio en los chips, que de otro modo estaría infrautilizado, podría destinarse a interruptores adiabáticos, porque no utilizarán una potencia significativa ni provocarán calentamiento.

Los circuitos adiabáticos hechos en CMOS están todavía en su infancia y en la actualidad tienen algunas limitaciones: “El CMOS adiabático mejora a bajas temperaturas y es especialmente bueno a temperaturas criogénicas”, dijo.

Quizás irónicamente, un campo que necesita electrónica que funcione a bajas temperaturas es el área bien financiada de la computación cuántica. Los bits cuánticos o "qubits" deben mantenerse a temperaturas criogénicas y debe eliminarse cualquier calor generado en los circuitos de control circundantes.

Podría ser que el silicio adiabático temprano se desarrolle para soportar circuitos en proyectos de computación cuántica, dijo Frank: "Esa puede terminar siendo una de las primeras aplicaciones comerciales de la lógica adiabática: obtienes algunos beneficios al operar a baja temperatura".

Hacer que funcione bien a temperatura ambiente requerirá más trabajo y nuevos tipos de componentes, incluidos resonadores que absorben energía y la recuperan, proporcionando los "frenos regenerativos" que necesita la descomposición.

“La energía requerida para el procesamiento de datos nunca será cero”, dijo Frank. “Ningún sistema es perfectamente eficiente. Todavía no conocemos los límites fundamentales de cuán pequeñas pueden llegar a ser las pérdidas. De manera más general, no conocemos los límites fundamentales de las tecnologías reversibles".

El grupo de Frank está empezando a obtener financiación y acceso a fábricas de chips personalizados, pero es lento: "Necesitamos más ingenieros que trabajen en este tipo de ideas. Tenemos la financiación para hacer chips de prueba. También es posible fabricarlos a través de fundiciones comerciales. Esa es otra vía que podemos seguir".

Independientemente de cómo suceda, sabemos que se necesita algo así, ya que el CMOS clásico se acerca al final de su desarrollo útil. "Nos estamos acercando al punto en el que no se puede ir más lejos". dijo Summers. “¿Se estancará la industria de los semiconductores y la gente perderá interés en ella? ¿O hará otras cosas? "

Frank y Summers están de acuerdo en que en los próximos diez años habrá una brecha entre el final de CMOS y cualquiera que sea la próxima tecnología. "Nadie sabe qué llenará ese vacío en este momento", dijo Frank. “Se están investigando una amplia variedad de cosas. No hay un ganador claro. No me sorprendería que hubiera un período de estancamiento. Se necesita bastante tiempo, unos diez años, para que una tecnología pase de funcionar en el laboratorio a la producción en masa".