En cierto punto, vale la pena dejar de generalizar. La inteligencia artificial ha recorrido un largo camino utilizando unidades de procesamiento de gráficos (GPU), un sector liderado por Nvidia. Ahora Intel está lanzando chips de formación e inferencia especializados como una alternativa de menor costo.

La especialista en inteligencia artificial Nervana tenía solo dos años cuando Intel la compró por alrededor de 400 millones de dólares en 2016. Desde entonces, la compañía ha sido absorbida como una división del gigante de chips y está trabajando arduamente para desarrollar circuitos integrados específicos de aplicaciones (ASIC) diseñados para entrenamiento e inferencia.

El fundador de Nervana, Naveen Rao, es ahora el vicepresidente corporativo y gerente general de inteligencia artificial de Intel. En noviembre, DCD lo alcanzó en la Cumbre de inteligencia artificial de Intel en San Francisco.

Entonces nos dijo que "con esta próxima fase de IA, estamos llegando a un punto de ruptura en términos de hardware y memoria computacional". En otras palabras, las GPU simplemente no van a cortarlo.

"El hardware especialmente diseñado como la gama Nervana NNP de Intel es necesario para continuar el increíble progreso en IA", dijo Rao.

"Verán que esto beneficia a todos porque todo el propósito de la computadora está cambiando a ser una máquina de inteligencia artificial".

"Parece que casi todas las aplicaciones necesitarán IA en el futuro, probablemente mucha inferencia y, en algún momento, capacitación".

Los dos aspectos centrales del aprendizaje profundo son la formación y la inferencia

El entrenamiento de IA implica alimentar grandes cantidades de datos en un modelo de IA infantil o red neuronal, una y otra vez hasta que el modelo pueda hacer una predicción precisa. La inferencia es el despliegue del modelo entrenado para tomar decisiones en el campo.

Estas funciones generalmente las realizan las GPU debido a su capacidad para calcular grandes cantidades de ecuaciones matemáticas. La GPU más nueva, más barata y de menor potencia que tiene Nvidia es la serie Tesla T4 de 70W.

Inferencia

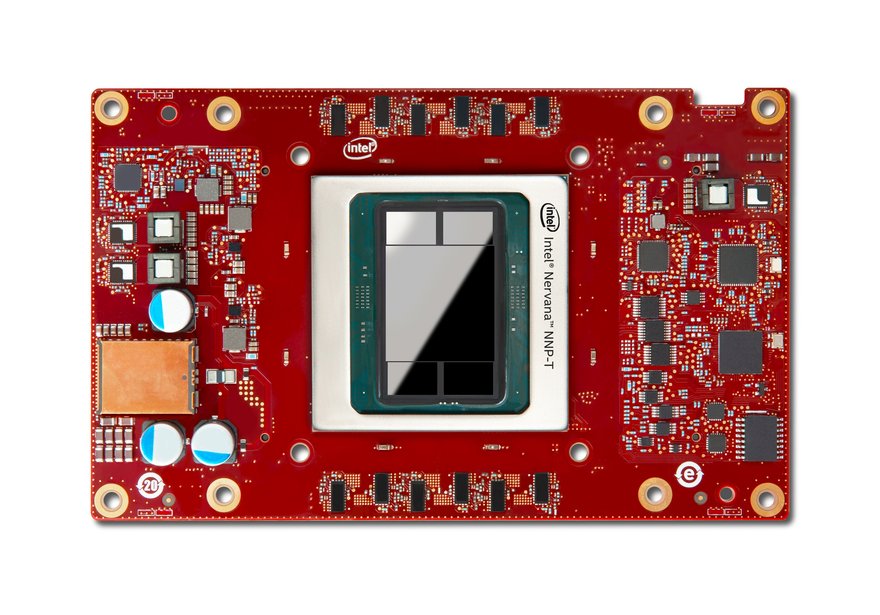

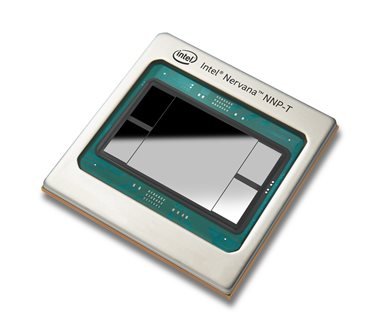

La gama NNP reemplaza la GPU con hardware especializado, realizando entrenamientos e inferencias en chips NNP-T y NNP-I separados, que usan menos energía y son mucho más escalables.

Por ejemplo, el chip de inferencia, el NNP I-1000, está disponible en dos productos: el NNP I-1100, una tarjeta de 12W que contiene un solo chip NNP-I, y el NNP I-1300, una tarjeta de 75W que contiene dos NNP-I chips.

“El poder importa. No se puede seguir arrojando un cómputo de rack de energía para resolver estos problemas en el mundo de IoT con centros de datos ”, dijo Rao.

El chip de entrenamiento más potente, el NNP-T 1000, contiene hasta 24 núcleos de procesamiento de tensor, junto con la memoria, y un enlace de comunicaciones rápido entre chips (ICL) con 16 canales de 112 Gb / seg.

Al igual que el chip Inference, el chip Training está disponible en dos productos: la tarjeta NNP-T 1300 de 300W y la tarjeta NNP-T 14000 de 375W.

A pesar de la importancia de la gama NNP, Intel todavía está lanzando GPU para casos más especializados.

Pocos días después de la Cumbre de IA, anunció que el primer sistema exascale de Estados Unidos, Aurora, albergaría la nueva GPU Ponte Vecchio de la compañía.

Descrito como el 'caballo de batalla' para la convergencia de HPC e IA, Ponte Vecchio es una potente GPU diseñada para asumir más funciones impositivas.

El vicepresidente y gerente general de Intel de Enterprise and Government Group, Rajeeb Hazra, dejó en claro que el gran plan de la compañía para la IA es tener un chip para cualquier necesidad particular, específica o general.

Se requerirá que Aurora realice tareas múltiples, de ahí la necesidad de GPU potentes.

Hazra dijo que "a medida que la informática de alto rendimiento pase del modelado y la simulación tradicionales a la llegada de los datos, habrá un impulso para diversas necesidades informáticas, lo que estimulará un nuevo viento de cola para la informática heterogénea.

"Una talla no sirve para todos. Debemos mirar las arquitecturas y cómo están ajustadas a las diversas necesidades de esta época.

"Si necesita una solución de propósito general, Ponte Vecchio ya ha descrito su desempeño de liderazgo para cuando obtenga esas cargas de trabajo que tienen enormes requisitos de ancho de banda y densas operaciones de punto flotante".

En cierto sentido, tienen un propósito menos general que la GPU, que ejecuta un conjunto más amplio de cargas de trabajo, pero están aguda y exclusivamente centradas en el aprendizaje profundo y la escala.

"Y eso es lo que creemos que es el enfoque correcto para un conjunto diverso de cargas de trabajo que también se están transformando con bastante rapidez a medida que la industria experimenta e innova".

CPU, GPU y ASIC

Para abreviar una larga historia, Intel quiere darles a los clientes una opción dependiendo de las circunstancias que enfrentan.

Naveen Rao dijo: “Las CPU tienen ganchos para ayudar con la inferencia y la capacitación para que los clientes puedan comenzar con Xeons [CPU], que probablemente ya tienen, o eventualmente pueden pasar a un NNP o incluso a un FPGA dependiendo de qué tipo de flexibilidad que necesitan ".

Dividir las funciones de aprendizaje profundo en ASIC como los dispositivos NNP no es en absoluto una idea "novedosa". También ha sido utilizado por Google, en su Unidad de procesamiento de tensor (TPU) y sus variantes de inferencia y capacitación, lanzadas en 2017 en su servicio en la nube.

Google tiene centros de datos llenos de TPU disponibles para alquilar. Los clientes notables que usan los procesadores incluyen Lyft, Twitter y HSBC.

En el evento AI Summit, Intel mostró un pod de 10 bastidores con 480 tarjetas NNP-T, usando sus enlaces ICL y sin interruptor externo. Esta plataforma entrenó modelos de parámetros multimillonarios en cantidades razonables de tiempo.

Según Intel, para implementaciones de campo, los chips NNP-I se colocarán dentro de un bastidor de servidor normal.

Las pruebas de Intel implicaron que el NNP-I golpearía a su rival, en una cuarta parte del espacio físico. Intel implementa el NNP-I en un chasis de unidad de rack único (1U), que contiene hasta 32 chips NNP-I en el factor de forma de "regla", un módulo largo y delgado.

Intel dijo que esto tenía 3,7 veces la densidad de un módulo 4U que se requeriría para contener 20 Nvidia Tesla T4.

Los primeros en adoptar

El compilador de aprendizaje automático de Facebook Glow ya usa el NNP-I. El director de inteligencia artificial del gigante de las redes sociales, Mikhail Smelyanskiy, dijo que : “Con 2.400 millones de usuarios hoy en día, hay muchos productos o servicios aparentemente no relacionados, pero en realidad, hay muchos algoritmos de inteligencia artificial que se ejecutan debajo. Y algunos ejemplos son el etiquetado de fotos [o traducción]”.

Del mismo modo, Baidu es uno de los primeros en adoptar el nuevo NNP-T. Kenneth Church, un investigador de IA en Baidu, dijo que la compañía se centró en implementar el chip de capacitación para Paddle-Paddle, una plataforma de aprendizaje profundo de código abierto en Baidu que utilizan 1.5 millones de desarrolladores en China y el chip para alimentar su X -Man Infraestructura de acelerador abierto 4.0.

Gadi Singer, vicepresidente del grupo de productos de IA y jefe del equipo de diseño en el NNP-I, le dio a DCD algunos detalles adicionales sobre su implementación. "A diferencia de otros servicios que se enfocaron muy específicamente en resolver un problema en particular, lo construimos para una familia de problemas [de despliegue general]", dijo Singer.

“Debido a los centros de datos necesitábamos algo que funcionara dentro de la infraestructura existente, permitiendo que los operadores de centros de datos simplemente conecten el bastidor a los enchufes de extensión.

“Está construido como una caja de herramientas. Cuando surgen nuevos usos, puede usar esto de una manera muy diversa y usar más de estos para escalar.

"Una cosa que está muy clara en nuestro espacio es que, cuando haya terminado de encontrar una solución a un problema, el problema ya ha cambiado".