Con el lanzamiento de ChatGPT en noviembre de 2022, fuimos testigos de uno de esos momentos excepcionales en que se siente como si el mundo estuviera viviendo en el futuro y no en el presente. La sorprendente facilidad con la que ChatGPT maneja el lenguaje, así como su capacidad para imitar con tanto detenimiento la inteligencia humana, generó asombro y activó las alarmas a partes iguales. De repente la IA era la consentida de Wall Street, mientras que las predicciones catastrofistas llenaban los encabezados.

Como muchas otras organizaciones, Nokia estaba interesada en ver qué podrían aportar la IA generativa y ChatGPT si fuera posible integrarlas con nuestras herramientas ya existentes. El resultado de este trabajo es una aplicación integrada en nuestro sistema operativo de red (NOS) SR Linux. Se llama "SR Linux GPT", y uno de nuestros ingenieros tardó un par de semanas en construirla. Describiré rápidamente qué hace la aplicación y cómo puede beneficiar a los ingenieros y los equipos de operaciones antes de pasar a las implicaciones a largo plazo para nuestros clientes.

ChatGPT y el lenguaje natural

En este punto, la mayoría de nosotros estamos familiarizados con los grandes modelos lingüísticos (LLM, por sus siglas en inglés) y lo que hacen. Para nuestro equipo de desarrollo, lo que les interesaba de ChatGPT era su capacidad para consultar información de la red y ayudar con la configuración de parámetros de red mediante un lenguaje cotidiano. Sus capacidades de procesamiento del lenguaje natural (NLP) le permiten participar y entablar conversaciones con base en las consultas hechas. ¿Acaso esta capacidad facilitaría que los ingenieros y los equipos de operaciones emitan comandos en lenguaje natural en lugar de comandos CLI (interfaz de línea de comando) tradicionales? Puede que no solo lo hiciera más fácil, más rápido y más eficiente, sino también podría reducir los errores.

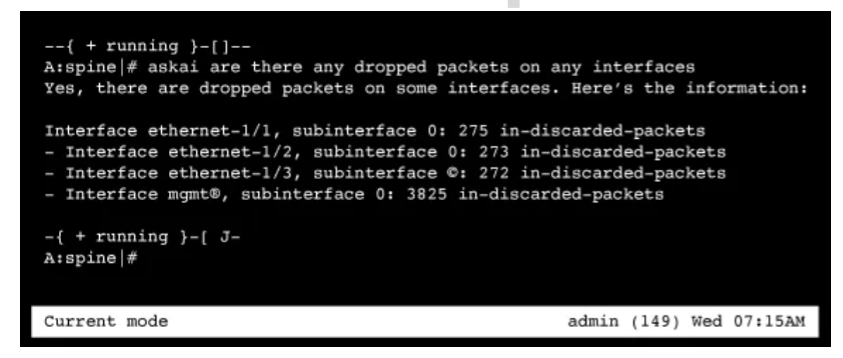

Con una interfaz de consola similar a ChatGPT, emitir comandos en lenguaje natural en lugar de utilizar el formato y la gramática de la CLI es mucho más natural y sencillo. Reduce la necesidad de conocimientos especializados de la CLI del proveedor y reduce los errores y el tiempo de recuperación de la información del sistema. Por ejemplo, puede emitir una directiva en lenguaje natural como “¿Hay paquetes perdidos en alguna de las interfaces?”

El contexto es quien manda

Nuestras pruebas iniciales de la nueva aplicación sí están a la altura de nuestras expectativas. Sin embargo, ¿qué pasa con la tendencia de ChatGPT a experimentar “alucinaciones”? Si ha estado siguiendo los debates más serios de ChatGPT, sabrá que la clave para obtener respuestas confiables de ChatGPT es establecer cuidadosamente el contexto de sus consultas. En este caso, nuestros ingenieros indicaron a GPT LLM de OpenAI que modelará sus respuestas basándose tanto en la documentación asociada a SR Linux y sus operaciones como en el estado de la red recibido a través de telemetría y registros. Esto garantiza que no invente respuestas basadas en conjuntos de datos diferentes, como la información disponible públicamente sobre otros NOS, por ejemplo.

AIOps de red

Esta integración de NLP es un caso de uso en evolución relacionado con las AIOps para redes. Las capacidades de las AIOps de red se pueden activar mediante una plataforma que integre OSS, BSS, gestión de red y automatización de red, o bien, se integran directamente en una plataforma de hardware de redes como un enrutador de IP o un conmutador de Ethernet. El objetivo final es aplicar los métodos basados en la IA para mejorar la experiencia del operador humano y los procesos cotidianos que sean más aptos para las necesidades comerciales únicas del operador.

Cuando se combinan con plataformas de IA como ChatGPT, las AIOps de red abren nuevas posibilidades y casos de uso en la automatización avanzada de la red y la mejora de las operaciones:

- Automatización de tareas manuales, tediosas y propensas a errores.

- Reducción de las incidencias abiertas.

- Detección y rectificación de fallos más rápido.

- Reducción del número de alertas para no saturar al personal de operaciones.

El análisis de la causa raíz y su resolución es otra área de las AIOps de red que está creciendo con rapidez. El software de aprendizaje automático se puede entrenar con datos históricos de telemetría para establecer un punto de referencia “normal” para la red. El punto de referencia le permite detectar anomalías y sugiere causas raíz para estas variaciones o eventos. La infraestructura mejorada con AI puede señalar el origen exacto del fallo y proporcionar un remedio para resolver el problema, digamos, el cambio que se necesita hacer en la configuración.

Una posible área de consideración puede ser el uso de una capacidad de gemelo digital de red dentro del sistema de gestión de materiales para hacer una revisión de estado del cambio en la emulación, liberándolo rápidamente a producción a través del flujo de trabajo de gestión de servicios de TI (ITSM, por sus siglas en inglés), una vez verificado. Se podría automatizar la totalidad del proceso de extremo a extremo a fin de permitir reparaciones predictivas antes de que los clientes noten siquiera el fallo.

Innovar con rapidez

Nuestra capacidad para adaptar una funcionalidad similar a ChatGPT tan rápidamente a SR Linux se basa en nuestra arquitectura NOS más moderna y abierta. Cuando creamos SR Linux, tuvimos la ventaja de ver qué era lo que más gustaba y disgustaba a nuestros clientes de los sistemas y herramientas heredados que utilizaban. Una de las quejas más frecuentes era que se sentían atrapados por las soluciones heredadas.

Afortunadamente para nosotros, el desarrollo de software en la era de la nube ha cambiado sustancialmente, con un mayor énfasis en la apertura y la extensibilidad en lugar de la integración monolítica. Construimos nuestro sistema en torno a Linux utilizando una arquitectura de microservicios y herramientas abiertas para que nuestros clientes, terceros y nuestros propios equipos pudieran innovar rápidamente y aprovechar avances como IA generativa cuando se produjeran.

Nuestro kit de desarrollo de NetOps (NDK) de última generación utiliza gRPC (Google Remote Procedure Call) y búferes de protocolo (Protobufs) para ofrecer la máxima flexibilidad en cuanto a los lenguajes admitidos, así como compatibilidad con versiones anteriores de nuestro NOS. Con SR Linux y su NDK, ha sido tan sencillo como crear una aplicación que se integre con la API OpenAI y ejecutarla directamente en la plataforma de hardware de red que ejecuta SR Linux. Creemos que se trata de una de las primeras implementaciones con este nivel de capacidad de integración estrecha del sector.

Dado que están diseñados para crear enunciados en lenguaje natural en respuesta a consultas cotidianas, los grandes modelos lingüísticos o LLM son algo único en su capacidad de llegar a la vida de los ciudadanos de a pie. Esto les ha valido una gran atención, pero lo cierto es que la IA ha obtenido resultados espectaculares en muchos frentes recientemente, la mayoría de ellos invisibles para el público en general. Como han señalado muchos comentaristas, nos encontramos en un punto de inflexión, en el que la tecnología de IA puede estar a punto de marcar el comienzo de una nueva era en el progreso humano.

Nos complace decir que nuestros clientes que ya disfrutan de la libertad y la apertura de SR Linux, estarán muy bien posicionados para integrar estas tecnologías revolucionarias en sus AIOps, tal y como hemos hecho con SR Linux GPT. Esta capacidad de innovar rápidamente le garantizará que se beneficiará de estos avances de la IA reduciendo los costos de las operaciones y mejorando e innovando los servicios que reciben sus clientes.

Para saber más sobre esta funcionalidad y probar su funcionamiento, vea Packet Pushers Video Byte y descargue la aplicación “SR Linux GPT” en el sitio Learn SR Linux.