Un nuevo informe escrito por un grupo de 19 académicos y respaldado por OpenAI afirma que los controles de la infraestructura digital detrás de los sistemas de inteligencia artificial podrían ser una forma eficaz de evitar que se haga un mal uso de la IA.

El documento sugiere medidas políticas como un registro global para rastrear el flujo de chips destinados a supercomputadoras de IA y "límites de cómputo": límites incorporados al número de chips a los que se puede conectar cada chip de IA.

Regulación de la IA y el papel de la potencia informática

La regulación de la IA se ha convertido en un tema candente entre los políticos durante los últimos 18 meses a medida que ha aumentado el interés en la tecnología.

En diferentes partes del mundo se están aplicando diferentes enfoques para controlar modelos grandes de lenguajes, como GPT-4 de OpenAI y Gemini de Google, que tienen el potencial de producir resultados perjudiciales, y la Unión Europea está elaborando una ley general sobre IA para regular sistemas, mientras que países como Estados Unidos y el Reino Unido han adoptado un enfoque más no intervencionista.

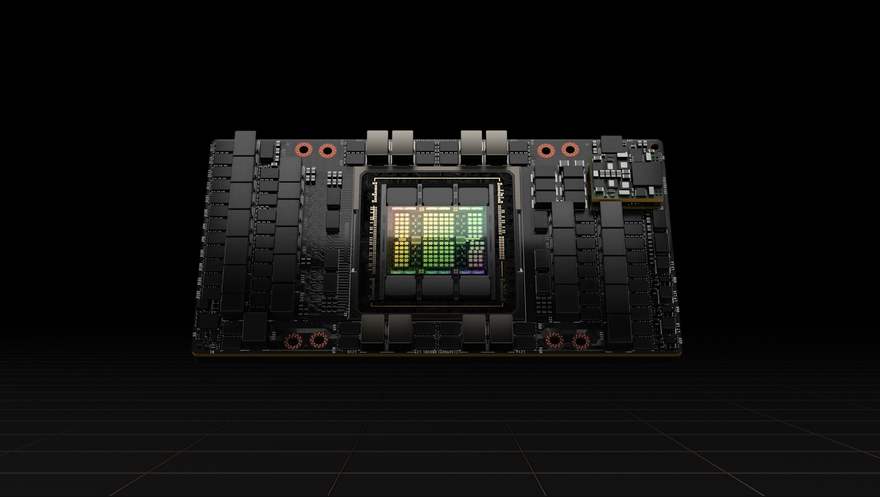

La mayor parte de la regulación se ha centrado en los propios sistemas de IA, más que en la potencia informática que hay detrás de ellos. La nueva investigación, titulada Computing Power and the Governance of Artificial Intelligence, dice que los chips de IA y los centros de datos ofrecen objetivos más eficaces para el escrutinio y la gobernanza de la seguridad de la IA. Esto se debe a que estos activos deben poseerse físicamente, mientras que los otros elementos de la “tríada de IA” (datos y algoritmos) pueden, en teoría, duplicarse y difundirse sin cesar.

La autoría del informe estuvo codirigida por tres institutos de la Universidad de Cambridge: el Centro Leverhulme para el Futuro de la Inteligencia (LCFI), el Centro para el Estudio del Riesgo Existencial (CSER) y el Instituto Bennett de Políticas Públicas, junto con OpenAI y organización de investigación el Centro para la Gobernanza de la IA.

"La inteligencia artificial ha logrado avances sorprendentes en la última década, muchos de los cuales han sido posibles gracias al fuerte aumento de la potencia informática aplicada a los algoritmos de entrenamiento", dijo Haydn Belfield, coautor principal del informe del LCFI de Cambridge.

"Los gobiernos están preocupados, con razón, por las posibles consecuencias de la IA y buscan cómo regular la tecnología, pero los datos y los algoritmos son intangibles y difíciles de controlar".

Por el contrario, Belfield dijo que el hardware informático es visible y cuantificable, y "su naturaleza física significa que se pueden imponer restricciones de una manera que pronto podría ser casi imposible con más elementos virtuales de IA".

Cómo se podría regular la potencia informática de la IA

El informe proporciona posibles direcciones para la gobernanza informática. Belfield utilizó la analogía entre el entrenamiento de IA y el enriquecimiento de uranio.

"La regulación internacional de los suministros nucleares se centra en un insumo vital que tiene que pasar por un proceso largo, difícil y costoso", afirmó. "Centrarse en la informática permitiría que la regulación de la IA hiciera lo mismo".

Las ideas de políticas sugeridas en el informe se dividen en tres áreas: aumentar la visibilidad global de la computación con IA, asignar recursos informáticos para el mayor beneficio para la sociedad y hacer cumplir las restricciones a la potencia informática.

Los autores argumentan que un registro internacional de chips de IA auditado periódicamente que exija a los productores, vendedores y revendedores de chips informar todas las transferencias proporcionaría información precisa sobre la cantidad de computación que poseen las naciones y las corporaciones en un momento dado. Se podría agregar un identificador único a cada chip para evitar el espionaje industrial y el “contrabando de chips”, aunque admiten que esto también podría conducir a un mercado de chips “fantasmas” o imposibles de rastrear.

"Los gobiernos ya rastrean muchas transacciones económicas, por lo que tiene sentido aumentar el seguimiento de un producto tan raro y poderoso como un chip avanzado de IA", dijo Belfield.

Otras sugerencias para aumentar la visibilidad –y la rendición de cuentas– incluyen informar sobre la capacitación en IA a gran escala por parte de los proveedores de computación en la nube y un “monitoreo de la carga de trabajo” que preserve la privacidad para ayudar a prevenir una carrera armamentista si se realizan inversiones masivas en computación sin suficiente transparencia.

"Los usuarios de computación participarán en una combinación de actividades beneficiosas, benignas y dañinas, y determinados grupos encontrarán formas de eludir las restricciones", dijo Belfield.

"Los reguladores necesitarán crear controles y contrapesos que impidan los usos maliciosos o equivocados de la informática de IA".

Estos controles podrían incluir límites físicos en las redes de chip a chip, o tecnología criptográfica que permita la desactivación remota de chips de IA en circunstancias extremas.

Las políticas de mitigación de riesgos de la IA podrían dar prioridad a la computación para la investigación que probablemente beneficie a la sociedad, desde la energía verde hasta la salud y la educación. Esto podría incluso tomar la forma de grandes “megaproyectos” internacionales de IA que aborden problemas globales mediante la puesta en común de recursos informáticos.

¿Es la regulación del poder de cómputo de la IA una perspectiva realista?

La participación de OpenAI en el artículo (Girish Sastry, un investigador de políticas en el laboratorio de IA, figura como coautor) puede sorprender a algunos, dado que se dice que Sam Altman, el director ejecutivo de la compañía, está intentando recaudar 7 billones de dólares para crear una vasta red de instalaciones de producción de chips de IA, una medida que podría inundar el mercado con aún más hardware.

Los autores del informe dijeron que sus sugerencias de políticas son “exploratorias” en lugar de propuestas completas y que todas conllevan desventajas potenciales, desde riesgos de filtración de datos patentados hasta impactos económicos negativos y obstáculos al desarrollo positivo de la IA.

Pero Belfield, de LCFI, añadió: “Tratar de gobernar los modelos de IA a medida que se implementan podría resultar inútil, como perseguir sombras. Quienes busquen establecer una regulación de la IA deberían mirar hacia arriba, hacia la computación, la fuente de poder que impulsa la revolución de la IA.

"Si la informática permanece sin control, plantea graves riesgos para la sociedad".