Oracle Cloud Infrastructure (OCI) ha hecho que las GPU Nvidia H100 Tensor Core estén disponibles de forma generalizada en OCI Compute.

Las GPU H100 estarán disponibles como instancias bare-metal de OCI Compute, dirigidas a aplicaciones informáticas de alto rendimiento e inteligencia artificial a gran escala.

Se ha descubierto que las H100 mejoran el rendimiento de inferencia de IA unas 30 veces y el entrenamiento de IA cuatro veces en comparación con las GPU A100 de Nvidia, aunque son difíciles de conseguir.

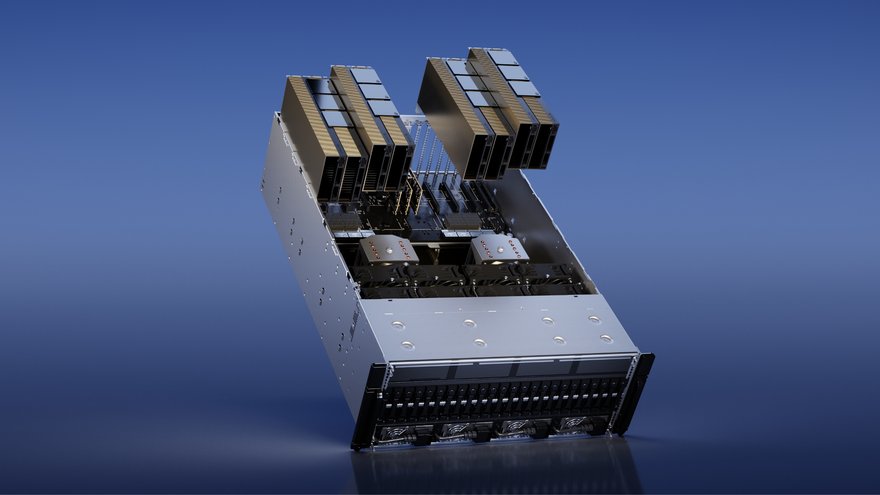

OCI Compute incluye ocho GPU H100, cada una con 80 GB de memoria GPU HBM2 y 3,2 Tbps de ancho de banda biseccional. La forma también incluye 16 unidades NVMe locales con 3,84 TB cada una y procesadores de CPU Intel Xeon de cuarta generación con 112 núcleos y 2 TB de memoria del sistema.

Los clientes también pueden utilizar OCI Supercluster para poner en marcha decenas de miles de H100 para una red de alto rendimiento.

Además del lanzamiento del H100, la GPU Nvidia L40S basada en la arquitectura Ada Lovelace estará disponible de forma generalizada a principios de 2024.

El chip, una GPU universal para centros de datos, está diseñado para inferencia y entrenamiento de modelos grandes de lenguaje (LLM), computación visual y aplicaciones de video.

Estas instancias ofrecerán una alternativa a las instancias H100 y A100 para proyectos de IA de tamaño pequeño a mediano y tareas de computación de gráficos y video.

El L40S puede ofrecer un aumento del rendimiento del 20 por ciento para cargas de trabajo de IA generativa y una mejora del 70 por ciento en el ajuste de los modelos de IA en comparación con el A100.

OCI no está sola en el despliegue de los H100. En agosto, Google anunció que lanzaría nuevas máquinas virtuales A3 con GPU H100 y procesadores escalables Xeon de cuarta generación que pueden crecer hasta 26.000 H100, y AWS comenzó a ofrecer GPU en julio como parte de sus instancias EC2 P5.

Nvidia ha visto su valoración dispararse más allá del billón de dólares debido a la demanda de IA, pero también ha habido una escasez significativa de GPU. Nvidia ofreció acceso prioritario a empresas de nube más pequeñas debido a la escasez, como CoreWeave y Lamda Labs. Desde entonces, el fabricante de chips ha invertido en el primero y está en conversaciones para invertir en el segundo.