Nvidia ha presentado la GPU H200, su última GPU de gama alta.

El H200 cuenta con 141 GB de HBM3e y un ancho de banda de memoria de 4,8 TBps, una mejora significativa con respecto a los 80 GB de HBM3 y 3,5 TBps de ancho de banda de memoria del H100. Por lo demás, las GPU son idénticas.

"Para crear inteligencia con aplicaciones generativas de IA y HPC, se deben procesar de manera eficiente grandes cantidades de datos a alta velocidad utilizando una memoria GPU grande y rápida", dijo Ian Buck, vicepresidente de hiperescala y HPC de Nvidia.

"Con Nvidia H200, la plataforma de supercomputación de IA de extremo a extremo líder de la industria ahora es más rápida para resolver algunos de los desafíos más importantes del mundo".

Se espera que los sistemas con tecnología H200 comiencen a distribuirse en el segundo trimestre de 2024. Los proveedores de nube AWS (Amazon Web Services), Google Cloud, Microsoft Azure, Oracle Cloud Infrastructure, CoreWeave, Lambda y Vultr implementarán instancias basadas en H200 a partir del próximo año.

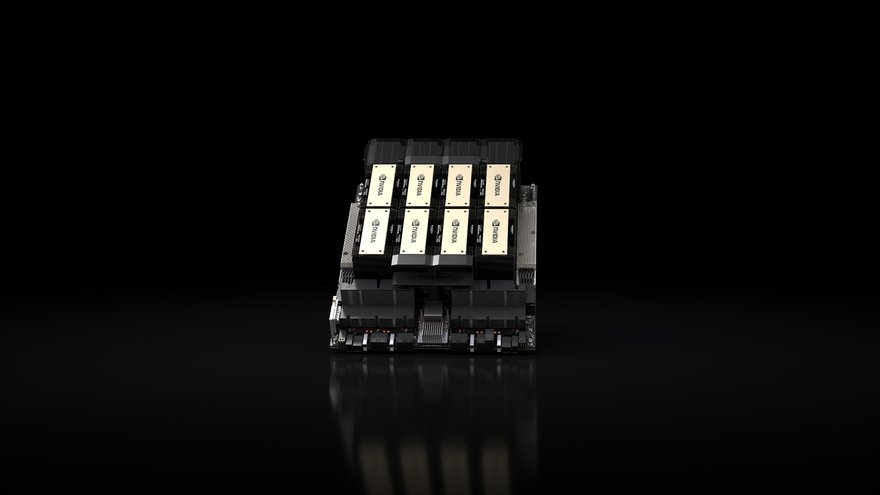

La GPU estará disponible en placas de servidor HGX H200 con configuraciones de cuatro y ocho vías, que son compatibles tanto con el hardware como con el software de los sistemas HGX H100.

Los fabricantes de servidores, incluidos ASRock Rack, ASUS, Dell Technologies, Eviden, Gigabyte, Hewlett Packard Enterprise, Ingrasys, Lenovo, QCT, Supermicro, Wistron y Wiwynn, podrán actualizar sus sistemas existentes con un H200.

H200 es parte del superchip Grace Hopper de segunda generación previamente anunciado, el GH200. Ese producto combina el H200 con su CPU Grace de 72 núcleos basada en Arm y 480 GB de memoria LPDDR5X en un módulo integrado.