Nvidia ha establecido nuevos récords de evaluación comparativa de rendimiento MLPerf en su GPU H200 Tensor Core y su software TensorRT-LLM.

MLPerf Inference es una suite de evaluación comparativa que mide el rendimiento de la inferencia en casos de uso de aprendizaje profundo.

La última versión de la suite de evaluación comparativa, MLPerf v4, ha visto la adición de dos nuevas cargas de trabajo que representan casos de uso de IA generativa: una prueba comparativa de modelo de lenguaje grande (LLM) basada en Llama 2 70B de Meta y una prueba de texto a imagen basada en en Difusión Estable XL.

Nvidia ha establecido récords de rendimiento en ambas cargas de trabajo, proporcionando el rendimiento más alto en todas las cargas de trabajo de MLPerf Inference en la categoría de centros de datos.

TensorRT-LLM de la compañía es una biblioteca de software de código abierto desarrollada para duplicar la velocidad de inferencia de LLM en sus GPU H100. En la prueba MLPerf v4 GPT-J, las GPU H100 que utilizan TensorRT-LLM lograron aceleraciones de 2,4x y 2,9x en los escenarios fuera de línea y de servidor, en comparación con el rendimiento proporcionado por las GPU seis meses antes durante la prueba v3.1.

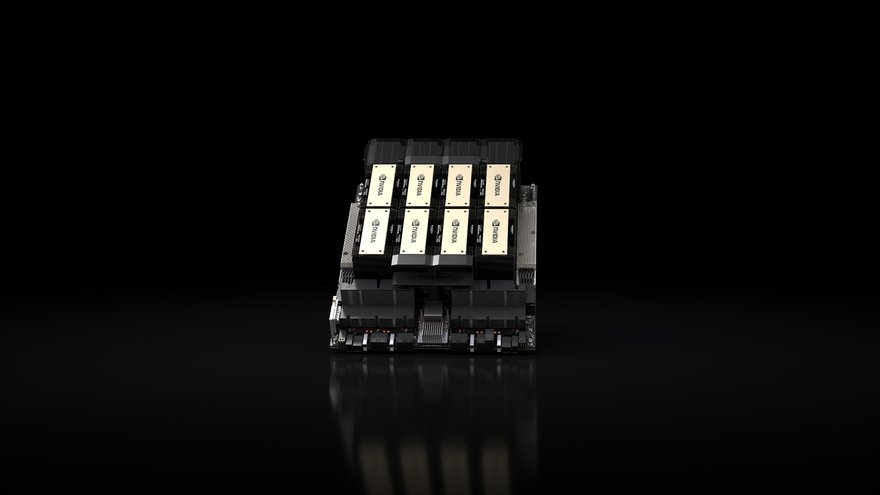

Para la prueba comparativa MLPerf Llama 2 70B, TensorRT-LLM de Nvidia ejecutado en las GPU H200 de la compañía entregó hasta un 43 por ciento y un 45 por ciento más de rendimiento en comparación con el H100 en los escenarios de servidor y fuera de línea, respectivamente, cuando se configuró con un TDP de 1000 W.

El nuevo punto de referencia utiliza la versión más grande de Llama 2, que tiene 70 mil millones de parámetros y es más de diez veces más grande que el modelo GPT-J LLM que se utilizó en pruebas de punto de referencia anteriores.

Con respecto a la prueba comparativa de texto a imagen de Stable Diffusion XL, un sistema Nvidia HGX H200 de 8 GPU con GPU configuradas para un TDP de 700 W logró un rendimiento de 13,8 consultas/segundo y 13,7 muestras/segundo en los escenarios de servidor y fuera de línea, respectivamente.

Cuando se ejecutó la misma prueba utilizando un sistema que contenía ocho GPU Nvidia L40S, el sistema demostró un rendimiento de 4,9 consultas/segundo y 5 muestras/segundo en los escenarios de servidor y fuera de línea, respectivamente.

Nvidia ha dicho que este es el mejor rendimiento logrado por cualquier solución de hardware durante la prueba Stable Diffusion XL.

Hablando antes de que se hicieran públicos los resultados, Dave Salvator, director de marketing de productos del grupo de computación acelerada de Nvidia, dijo que la inferencia se ha convertido en una gran parte de las actividades y negocios del centro de datos de Nvidia, y señaló que en 2023 representó alrededor del 40 por ciento de los ingresos del centro de datos de la empresa.

Sin embargo, señaló que no es sólo en las dos nuevas pruebas MLPerf donde Nvidia ha registrado resultados récord de rendimiento.

"[Nvidia] se entrega en cada carga de trabajo porque no sólo es importante poder ofrecer un gran rendimiento en una sola carga de trabajo, sino que también es importante ofrecer un gran rendimiento en tantas cargas de trabajo como sea posible", afirmó. “[En las nueve pruebas de MLPerf] continuamos brindando resultados líderes en todas esas cargas de trabajo, en todos esos casos de uso.

"Esto es algo realmente importante porque significa que nuestra plataforma no sólo es muy, muy eficaz, sino que también es muy versátil, y eso es algo que nuestros clientes realmente aprecian y valoran", dijo Salvator.