Lo primero que todo el mundo menciona sobre Cerebras es su tamaño.

A lo largo de múltiples entrevistas con DCD , el CEO de la compañía intentó llamar nuestra atención sobre otros beneficios potenciales de la arquitectura del chip y cómo la startup planea construir un negocio de inteligencia artificial sostenible.

Y, sin embargo, inexorablemente, por mucho que lo intentáramos, volvíamos al tamaño de sus chips.

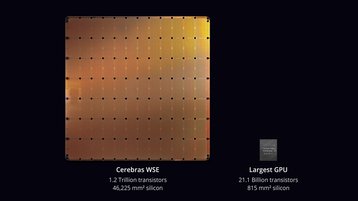

El chip más grande del mundo, el Wafer Scale Engine 2, tiene 2,6 billones de transistores, significativamente más que la GPU H100 de gama alta de Nvidia, que alcanza los 80.000 millones. Construido sobre TSMC de 7 nm, el WSE-2 tiene 850.000 núcleos "optimizados para IA", 40 GB de memoria SRAM en el chip, 20 petabytes de ancho de banda de memoria y 220 petabits de ancho de banda de tejido agregado.

Para aquellos que pueden permitírselo, se puede comprar como Cerebras CS-2, una caja de 15U que también incluye CPU SuperDome Flex de HPE y AMD para una potencia máxima sostenida del sistema de 23kW. "Es un millón y medio de dólares, más o menos", dijo el director ejecutivo Andrew Feldman.

Pero no volamos a Santa Clara para ver algo en las miserables siete cifras.

Fuimos para ver la computadora superpoderosa que Cerebras ha construido a partir de múltiples sistemas CS-2: Andrómeda.

Con 16 CS-2, 18.176 núcleos AMD Epyc Gen 3 y unos 13,5 millones de núcleos, Andromeda es una de las supercomputadoras más potentes del mundo, al menos en los puntos de referencia de IA de precisión simple, donde publica más de un exaflop de cómputo.

Cerebras ofrece Andrómeda como servicio en la nube. Feldman dice que algunos clientes utilizarán el servicio para probar la arquitectura única, antes de continuar con una compra mayor (más sobre esto más adelante). Otros lo utilizarán como una plataforma en la nube continua en lugar de comprar su propio equipo.

Andrómeda es el comienzo de un plan audaz para hacerse con una porción del creciente mercado de la IA, y su centro de datos también ve esto como una oportunidad.

La supercomputadora se encuentra en una instalación de colocación dirigida por Colovore. Después de años como operador de nicho de una sola instalación, Colovore ve el sistema Cerebras y otros similares como un punto de inflexión crítico, donde los requisitos de alta densidad de las cargas de trabajo de IA finalmente cambiarán la industria de los centros de datos hacia la refrigeración líquida.

Colovore espera expandirse por todo Estados Unidos y construir la próxima generación de centros de datos.

Usando una oblea entera

Pero antes de eso, debemos volver al tamaño. Cerebras pretende construir un producto del tamaño de una oblea semiconductora, que en teoría es lo suficientemente grande para los desafíos actuales.

"Cuando empezamos a jugar con la idea y cuando iniciamos la empresa en 2016, vimos la necesidad de una enorme cantidad de computación", explicó Feldman.

Los semiconductores se fabrican en obleas circulares de 300 mm de ancho. Un chip complejo puede ocupar 800 milímetros cuadrados y, normalmente, los fabricantes de chips obtienen alrededor de 60 de ellos de una sola oblea. Las Cerebras necesitaban más que eso.

"Pensamos que iba a ser mucho más de lo que podía ofrecer un solo chip tradicional de 800 milímetros cuadrados. Y eso significaba que era necesario unir los chips. Había dos maneras de hacerlo: un enfoque innovador, que era nuestro enfoque, o salir y comprar una empresa de telas y pensar en cómo unirlas de maneras muy tradicionales".

Nvidia tomó la ruta tradicional, compró Mellanox y utilizó su interruptor de tejido para ofrecer megachips virtuales uniendo chips: "Básicamente, todos estos chips comienzan en la oblea y luego se cortan. Y luego se compra más equipo para unir "Vuelve a unirlos. Esa es la elegancia, si mantienes a Humpty Dumpty entero, no tienes que usar pegamento y todo eso para volver a unirlo".

Cerebras espera que su chip Humpty Dumpty esté listo para un momento único en el hardware de TI. El lanzamiento de ChatGPT y la ola generativa de exageración de la IA resultante representa una oportunidad única para definir una nueva generación de hardware, más allá de los mercados tradicionales de CPU y GPU.

Sin embargo, ese auge destacó dos cosas: primero, que el nuevo mercado está liderado por una empresa de código cerrado, OpenAI. Y segundo, que ni siquiera el megachip de Cerebras es lo suficientemente grande para lo que está por venir.

Sobre el primer punto, Feldman señaló que "es malo para otros proveedores de hardware si hay un número muy pequeño de proveedores de software muy poderosos, malo para el ecosistema, malo para la innovación y malo para la sociedad".

Al ver la oportunidad, Cerebras ofreció Andrómeda a la comunidad de IA y pudo lanzar rápidamente sus propios modelos generativos, con siete modelos que van desde 11 millones de parámetros hasta 13 mil millones (se rumorea que GPT-4 tiene más de un billón).

Si bien los modelos no pueden competir con los de OpenAI, sirvieron para un propósito: mostrar a la comunidad que puede ser fácil trabajar con el hardware de Cerebras y demostrar que puede escalar.

Ese es el argumento de otro tamaño que plantea Cerebras. La compañía afirma un escalado lineal casi perfecto en múltiples CS-2.

Feldman sostiene que la gran arquitectura significa que puede ajustar todos los parámetros de un modelo en la memoria fuera del chip y dividir el cálculo en partes iguales entre varios chips. "Como resultado, cuando anotamos 16, 32 o 64 para un cliente, dividimos los datos por ese número, enviamos una fracción de los datos a este chip, y cada uno de sus amigos, promedia los resultados y tarda aproximadamente una 16.ª vez o una 32.ª vez.

"Esa es una característica de poder hacer todo el trabajo informático en un solo chip; es uno de los enormes beneficios de ser grande".

Beneficios para el anfitrión

Si bien la empresa se ha centrado en ser grande, el host de su centro de datos siempre se ha beneficiado de ser pequeño.

Colovore es un operador pequeño, cuya única instalación apenas puede albergar a Cerebras, Lambda Cloud y otros en el sitio. Lanzado en 2013, se abrió un mercado igualmente pequeño en racks refrigerados por líquido con capacidad de hasta 35 kW.

"Ya no creemos que la refrigeración líquida sea un nicho", dijo el director financiero y cofundador Ben Coughlin. "Creo que con la adopción de la IA, esto se está volviendo mucho más común. Por eso creo que estamos pasando rápidamente de un mercado pequeño y definido a algo mucho más grande. Creemos que hay una gran oportunidad".

Mientras que otros todavía están intentando definir su estrategia de refrigeración líquida y se están acostumbrando a nuevos diseños y procesos, Colovore tiene una década de experiencia.

"Si miramos a nuestros compañeros operadores de centros de datos, será un desafío para ellos tener que girar o adaptarse", dijo Coughlin. "Tienen diseños muy estándar que utilizan, y lo han utilizado con bastante éxito, pero son fundamentalmente diferentes. No es tan fácil pasar del aire al líquido".

El CTO, cofundador y ex director del centro de datos de Google, Peter Harrison, coincidió: "[Los principales colos] perciben la revolución de la IA, pero sienten que este no es el momento de hacer esa inversión.

“En parte se debe a que tienen todos estos costos en instalaciones más antiguas, y si admiten el hecho de que este nicho se ha vuelto cada vez más común, corren el riesgo de que los mercados los castiguen diciendo que sus centros de datos están obsoletos.”

Harrison cree que los hyperscalers no están esperando a que los mayoristas se pongan al día y están modernizando sus propias instalaciones y evitando a los intermediarios.

"Y entonces, cuando los principales actores dicen que no ven la IA, es posible que en realidad no la vean en absoluto. En realidad, simplemente están siendo ignorados".

Muchas marcas más grandes también se dirigen a clientes con ingresos comprobados, algo de lo que carece la nueva generación de startups de IA. "Por lo tanto, muchas nuevas empresas tienen dificultades al intentar involucrarse en muchas de estas instalaciones", dijo Harrison.

"Las instalaciones requieren un contrato a largo plazo y grandes cantidades de compromiso inicial para la capacidad", añadió. "Es posible que una startup no necesariamente sepa exactamente qué puede ser porque no conoce su demanda. Por eso permitimos que las empresas comiencen con un gabinete y puedan aumentar un gabinete a la vez".

Este enfoque, junto con sus capacidades de enfriamiento, ha hecho que Colovore esté de humor para expandirse tan rápido como una de las nuevas empresas que alberga. La empresa está empezando cerca de casa y recientemente compró un edificio adyacente para convertirlo en un centro de datos de 9 MW. Entonces mirará más lejos.

Coughlin explicó: "Tenemos planes de expandirnos y agregar más capacidad tanto dentro como fuera del mercado. Estamos planificando mucho con nuestros clientes para determinar adónde ir.

"Creemos, fundamentalmente, que esta alta densidad y alta capacidad de procesamiento de transacciones debe estar en las principales áreas metropolitanas, porque ahí es donde se generan, gestionan, almacenan y analizan los datos".

La compañía afirma tener un diseño de centro de datos estandarizado para entornos relativamente secos y muy húmedos, lo que convierte a la mayoría de las áreas metropolitanas de EE.UU. en sitios potenciales. "Hay varios mercados desatendidos en Estados Unidos que creemos que también necesitarían estas instalaciones", añadió Harrison.

"Los mercados que me vienen a la mente serían como Detroit".

Mientras otras empresas todavía están trabajando en su estrategia de liquidez, Coughlin cree que "a corto plazo tenemos la oportunidad de crecer rápidamente y ampliar nuestro negocio".

También espera poder mantenerse a la vanguardia con el nivel de enfriamiento. "Cuando utilizamos líquido directo, podemos obtener diseños de hasta 300 kilovatios en un solo rack", dijo Coughlin.

Para su configuración básica, la empresa ofrece refrigeración líquida a través de un intercambiador de calor de puerta trasera, que puede admitir hasta 50 kW en un gabinete.

"Dimensionamos las tuberías en la parte frontal para poder entregar las densidades más altas, pero si un cliente viene y dice que solo necesito 10 kW en un gabinete, simplemente no proporcionamos tanta agua en ese rack. Podemos controlar el caudal de cada uno", afirmó Coughlin.

Pero a pesar de toda la experiencia de la empresa con la refrigeración líquida, ir más allá de su único edificio sería un gran salto. ¿Quizás, sugirió DCD , que la empresa podría trabajar con su inversor Digital Realty?

“Al pasar a la siguiente fase, estamos muy, muy abiertos a asociarnos con Digital, ellos tienen presencia en todos los mercados a los que nos gustaría dirigirnos.

"Y hemos hablado con ellos informalmente sobre el lanzamiento de Colovore como su oferta de alta densidad", admitió Coughlin.

Aurora se encuentra con la galaxia

Mientras hablábamos, otra discusión informal estaba a punto de concluir. Apenas unas semanas después de la visita, G42, cliente de la nube de Cerebras, firmó un acuerdo importante con la compañía de chips, inicialmente para construir una nueva supercomputadora enorme en las instalaciones de Colovore.

La empresa de inteligencia artificial con sede en los Emiratos Árabes Unidos, que está controlada por el hijo del fundador del estado y ha sido acusada de espiar a ciudadanos, disidentes y extranjeros de los Emiratos Árabes Unidos, recurrió a Cerebras para construir la supercomputadora Condor Galaxy. Ya implementado, tiene 27 millones de núcleos informáticos de IA, con dos exaflops de rendimiento de IA de precisión simple.

Dentro de unos meses esa supercomputadora duplicará su tamaño. En la primera mitad de 2024, dos más entrarán en funcionamiento en diferentes centros de datos, uno en Austin, Texas, y otro en Asheville, Carolina del Norte, y luego se planean seis más más adelante este año. En total, son 36 exaflops de rendimiento de precisión simple y 489 millones de núcleos de IA.

"Estos chicos buscaban establecer una asociación con una empresa que pudiera construir, administrar y operar supercomputadoras y que pudiera implementar modelos de IA generativa muy grande, y tuviera experiencia en manipular, limpiar y administrar enormes conjuntos de datos", dijo Feldman de Cerebras sobre el acuerdo. Se cree que vale más de 100 millones de dólares por sistema.

"Existe la idea errónea de que las únicas personas que podrían construir clústeres de este tamaño son los hyperscalers en los EE.UU. Eso es claramente erróneo. Se están construyendo en todo el mundo. Y hay empresas de las que mucha gente en los EE.UU. no ha oído hablar. "Tenemos una demanda de IA por valor de cientos de millones de dólares".

Y añadió: "Es extraordinariamente emocionante, es una nueva fase para la empresa. Como startup, la razón por la que sueñas a lo grande es para clientes como este".

Ya sean chips o sueños, cualquier conversación sobre Cerebras vuelve a cobrar importancia.