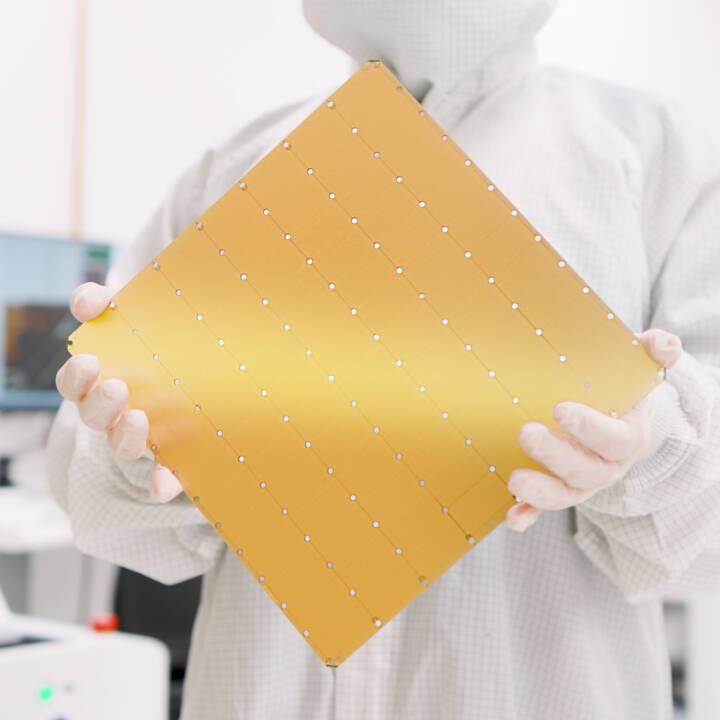

A Cerebras Systems apresentou a última versão de seu semicondutor do tamanho de um pequeno disco.

O Wafer Scale Engine 3 possui quatro bilhões de transistores e 900.000 'núcleos AI', junto com 44 GB de SRAM no chip.

Quando se combina com o sistema Cerebras CS-3, a empresa afirma que o chip é capaz de gerar 125 petaflops de IA máximos. Isso pode ser ampliado até 2048 CS-3 em um só cluster, para supostos 256 exaflops de computação de IA.

“Não o construímos desse tamanho por ser fácil e atrativo, mas não somos somente 52 vezes maiores [que um GPU Nvidia], como temos 52 vezes a quantidade de núcleos, mais de 800 vezes a memória no chip, e mais de três ordens de magnitude acima e largura de banda de comunicação”, disse à DCD o vice-presidente de produto da Cerebras, o Dr. Andy Hock.

Em comparação com o WSE-2, “é o mesmo quadrado maior que podemos cortar do maior silício primário circular que podemos comprar”, disse Hock. “Será o dobro do rendimento para o trabalho com IA, dentro do mesmo nível de potência e preço".

A empresa nunca revelou oficialmente o preço de seus chips, mas se acredita que custam entre 2 e 3 milhões de dólares (10 a 15 milhões de reais). Hock disse que um CS-3 usa 23kW.

Além do novo chip, a empresa disse que completou a construção do Condor Galaxy 2, seu segundo supercomputador na nuvem construído como parte de um acordo de 900 milhões de dólares (4,5 bilhões de reais) com G42.

“Agora estamos construindo a terceira máquina Condor Galaxy”, disse Hock, e essa inclui CS-3.

A Cerebras também se associou com a Qualcomm para implementar os chips Cloud AI 100 Ultra para trabalhos de inferência com os supercomputadores de treinamento.

Hock disse que a empresa estava treinando especificamente modelos para que funcionassem bem nos chips de inferência, o que “eliminaria uma grande fração de cálculos desnecessários de operações de multiplicação por zero”.