La refrigeración es uno de los pilares fundamentales sobre los que se sustenta la continuidad del Data Center. Estas infraestructuras críticas albergan en su interior los datos, el activo más valioso de las diferentes empresas, por tanto, la producción de calor que generan los equipos en el interior de las salas es uno de los principales focos de preocupación de los administradores de centros de datos.

Por este motivo, es de vital relevancia contar con un buen diseño del sistema de cooling, (que, además de climatizar, controle la humedad), adaptado a las necesidades de crecimiento de la infraestructura y que camine al ritmo de los avances tecnológicos. Desde DCD hemos hecho una recopilación de todas las novedades y experiencias que los protagonistas de la industria compartieron en nuestro evento virtual Keeping IT Cool.

Operaciones de enfriamiento: ¿en qué situación estamos? ¿A qué desafíos nos enfrentamos?

El enfriamiento del Data Center es uno de los focos donde se puede obtener un mayor ahorro de energía. No obstante, al desempeñar un papel fundamental en la continuidad operativa, cada mejora conlleva un riesgo significativo para las operaciones y la eficiencia energética. Entonces, ¿cuáles son los mayores desafíos a los que se enfrenta la industria cuando se trata de refrigeración que potencialmente podría comprometer tanto las operaciones del centro de datos como el PUE?

Robert Tozer, managing director de Operational Intelligence, enumera 10 desafíos para las operaciones de cooling en los Data Centers en particular:

- El elemento humano: posibilidad de toma de decisiones erróneas y pueden existir problemas en los sistemas sin identificar

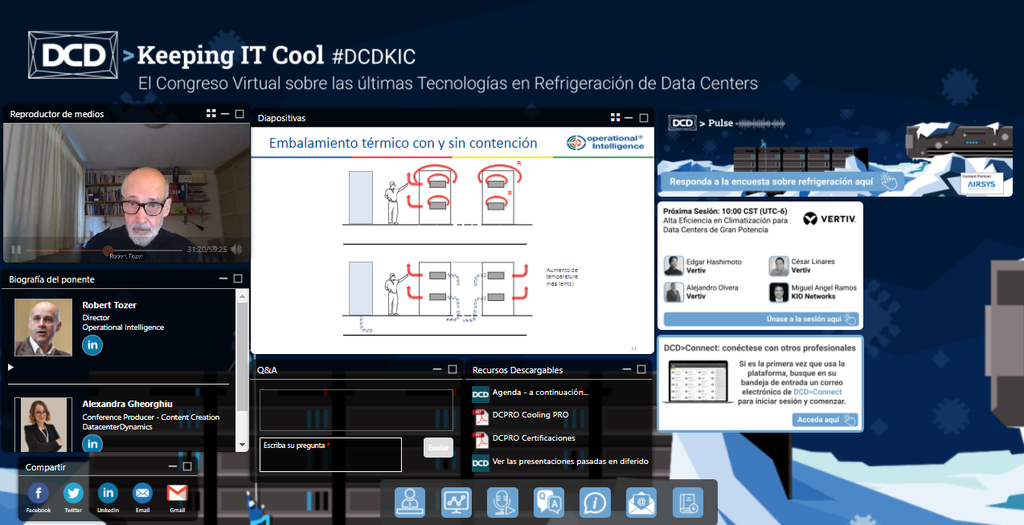

- Gestión del aire: los problemas que puedan estar sucediendo no se detectan a simple vista, lo que repercute en falta de ahorro de energía y poca fiabilidad. “El sistema de contención no garantiza una buena segregación del aire, ni el correcto balance de caudales”, explica Robert.

- Fundamentos de ahorro de energía: “Existe poco conocimiento de las posibilidades de free cooling. En general, en Latam se puede aplicar esta técnica y en Europa en gran parte”, explica Robert Tozer.

- Plan de commissioning (puesta en servicio)

- Equipamiento de operaciones en todo commissioning: “El otro problema es que le dicen al equipo de operaciones que participen para ahorrar dinero. Se ha perdido el tiempo de hacer pruebas y jugar con los sistemas y cuando les llega el proyecto solo le queda al equipo de operaciones hacer funcionar el Data Center sin el menor conocimiento. No ha ocurrido esa transferencia de conocimiento”, cuenta Tozer.

- Contar con la documentación apropiada para operaciones

- Controles: sistemas de monitorización y protocolo de gestión de alarmas

- El impacto de las estrechas condiciones interiores de temperatura y humedad

- Brecha entre la percepción de ventas y la realidad: “Vende el sueño y las operaciones tienen que entregar la pesadilla”

- Capacitación enfocada en enfriamiento para equipos de operaciones

ENCUESTA: ¿Cuándo el enfriamiento por líquido de equipos de TI va a sobrepasar el enfriamiento por aire?

- 2022: 2%

- 2024: 18,4%

- 2027: 34,7%

- 2032: 28,6%

- 2040: 16,3%

Si nos enfocamos en el futuro: “El chip necesita un disipación de calor y el tamaño de este disipador se está haciendo cada vez más grande, por lo que necesito un nuevo tipo de tecnología. Para mí es lo que está impulsando el cambio y ocurrirá cuando la densidad del chip supere los 250W”, expresa Robert Tozer. En este sentido, también aparecen otros nuevos desafíos cuando se introduce otro elemento de los equipos de TI, los líquidos.

Obtener una alta eficiencia energética en la climatización, una de las metas a conseguir

El consumo energético de los Data Centers va en aumento, un crecimiento que es aún mayor con el auge de grandes infraestructuras que requieren enormes cantidades de potencia, como es el caso de los hiperescala que se expanden en Latinoamérica. César Linares, Sales Executive Manager Data Center Perú de Vertiv indica que en el caso de los hiperescala hay mucha preocupación por tener un funcionamiento óptimo y consumir lo menos posible, dado el gran tamaño de sus instalaciones. En este sentido, el PUE es un indicador que muestra la efectividad del uso de la energía y cuanto menor sea, más eficiente será el Data Center. “Un PUE cuyo número decimal se pueda reducir un solo dígito, puede representar un ahorro de 750.000 dólares en 10 años en una instalación de 1MW”, apunta Linares a modo de ejemplo de la gran relevancia que tiene esta métrica.

Considerando que lo que se busca es reducir lo máximo posible las cantidades de energía sin sacrificar las condiciones óptimas de enfriamiento o climatización de la sala, se identifica que hay un gran consumidor dentro de la parte eléctrica: el aire acondicionado, el 34%-50% del consumo lo representa solo este elemento. Por ello, se manejan diversas soluciones para reducir su uso. “Las mejores condiciones para las aplicaciones eficientes se encuentran en la parte intermedia superior y en la parte inferior sur y es muy fácil conseguir valores altos de eficiencia energética en el norte. Poner un Data Center ahí es bastante amigable. En Chile o en Argentina, por ejemplo, en ciertas épocas del año la temperatura juega un papel muy importante a favor del ahorro energético”, explica César Linares.

En este punto, recomienda utilizar enfriamiento adiabático: evaporativo y por inmersión. “La combinación del agua exterior con componentes adiabáticos más compresores de real capacidad variable permiten usar un enfriamiento bastante óptimo desde el punto de vista del ahorro energético y adaptación o adecuación a las temperaturas del agua requeridas para la aplicación”, argumenta Linares.

Por su parte, Alejandro Olvera, Application Engineer Thermal Management México de Vertiv y Edgar Hashimoto, Application Engineer Latam-Brasil de Vertiv, se enfocaron en otra de las técnicas de enfriamiento utilizadas actualmente e hicieron una aclaración: “Se puede utilizar free cooling directo, pero hay que pensar bien en los agentes contaminantes externos presentes en el aire, mientras que al emplear el indirecto se elimina la posibilidad de contaminación o ingreso de humedad del aire”.

En este camino hacia la mejora de la eficiencia y optimización del sistema de enfriamiento, Miguel Ángel Ramos, Director Global Data Center Operations de KIO Networks, nos relató cómo desde la compañía han conseguido ahorrar 350.000 dólares al año gracias a 7 acciones que pusieron en marcha para mejorar su método de cooling, también como parte de su compromiso con el medio ambiente:

- Calibramos todos los elementos de medición para que los cálculos fueran correctos: cámaras termográficas, sensores de humedad y temperatura.

- Obtener un rayos X de la situación inicial: por delante y detrás de los gabinetes de temperatura, así como el consumo eléctrico de cada elemento del sistema de enfriamiento.

- Hacer un análisis de los datos para generar un plan de acción, utilizando la metodología de Robert Tozer y Vertiv.

- Aplicar las mejoras dentro de la sala: gabinetes, equipos electrónicos encendidos, aplicando principios básicos de gestión del aire.

- Mejoras hacia los crah: ajustar los set points de temperatura y humedad. Otro punto clave para ahorrar energía fue la aplicación de la ley de PUE.

- Optimización del sistema de free cooling directo con el objetivo de aprovechar más las horas de aire exterior y reducir el consumo de los chillers. 10 meses al año para aprovechar el aire exterior con las mejoras.

- Automatizar todo lo anterior para mejorar la eficiencia energética constantemente (mediante IA, machine learning y robots).

“El PUE se redujo del 1.8 al 1.3 y el objetivo es llegar a 1.2”, asegura Miguel Ángel Ramos.

Por tanto, para iniciar proyectos de eficiencia energética, los principios básicos son: 1) medir el PUE para saber dónde estamos y apagar equipos que no estén dando valor al negocio; 2) antes de modificar los set points de temperatura, aplicar las reglas básicas de gestión de aire (paneles ciegos, que los equipos tengan la dirección de flujo de aire de pasillo frío-caliente, peinar el cableado dentro de los racks y abajo del falso suelo…); 3) modificar la parte de temperatura. Los cambios de temperatura deben ser graduales porque el Data Center está en funcionamiento.

En línea con esto anterior, y teniendo en cuenta que los equipos IT han evolucionado y demandan mayor densidad de potencia y, por lo tanto, mayor capacidad de refrigeración, Javier Montemayor, Director de Operaciones España de Interxion, compartió un caso práctico de adecuación del sistema de refrigeración en el Centro de Datos sin impacto en el servicio en su Data Center Mad1, construido en Madrid en el año 2001.

Se decidió adecuar el sistema de refrigeración del Data Center, dado que con el paso del tiempo, con la llegada del cloud y el desarrollo de la economía digital, los equipos de TI de los clientes fueron necesitando más potencia eléctrica y refrigeración. Tanto es así que pasaron de una densidad de 0,8kW/m2 y un set point de refrigeración de 7º-12º en el año 2000 a una densidad de 2,4kW/m2 y un set point de refrigeración de 20º-30º. Por tanto, decidieron embarcarse en este proyecto de 18 meses de duración en los cuales se ha instalado un segundo anillo de agua, se han sustituido 42 CRACs y se han cambiado 5 enfriadoras de 450kW (35º exteriores) por 4 Cooling Generating Module (Chillers + Dry Coolers) de 700kW (45º exteriores).

Los resultados de este trabajo se traducen en un mayor número de horas de free cooling (2700 horas vs 7700 horas con la configuración actual), funcionamiento con doble set point, mayor capacidad de producción de frío y un ahorro anual de 101.000 euros. “Uno de los principales puntos fue cambiar la estructura mecánica que estaba en la azotea. Se pudo hacer sin ninguna afectación del sistema”.

“Hay que buscar la eficiencia energética, con la configuración de 35º exteriores, el contexto medioambiental actual y considerando todos los aspectos técnicos, la situación era que no teníamos la capacidad de soportar la carga ante un escenario de fallo (riesgo) y no estaba diseñado para las nuevas temperaturas y los estándares marcados por Interxion que eran de 45º”.

El cuidado del medioambiente: otra de las prioridades

“La industria de la refrigeración y la climatización ha sufrido muchas presiones fruto de la presión por la conciencia de la humanidad por el cambio climático y siempre ha estado en la búsqueda de producir nuevos refrigerantes más amigables y verdes”, comenta Néstor Hugo Salinas, Arquitecto de Soluciones para Datacenters de Schneider Electric. En este sentido, tras hacer un repaso por los diferentes refrigerantes que se han ido utilizando a lo largo del tiempo, señala que “R22 fue el rey de los refrigerantes más utilizados, después migramos hacia r407c y hoy en día se está utilizando y migrando a r410a y r134a”.

ENCUESTA: ¿Ha considerado el uso de agua dentro de su Data Center?

- Sí 88%

- No 12%

Fuente: Schneider Electric

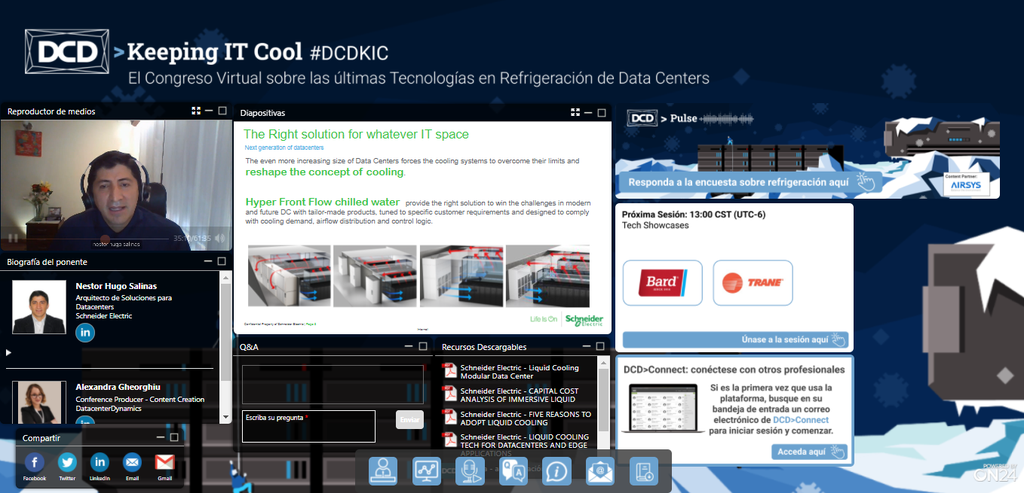

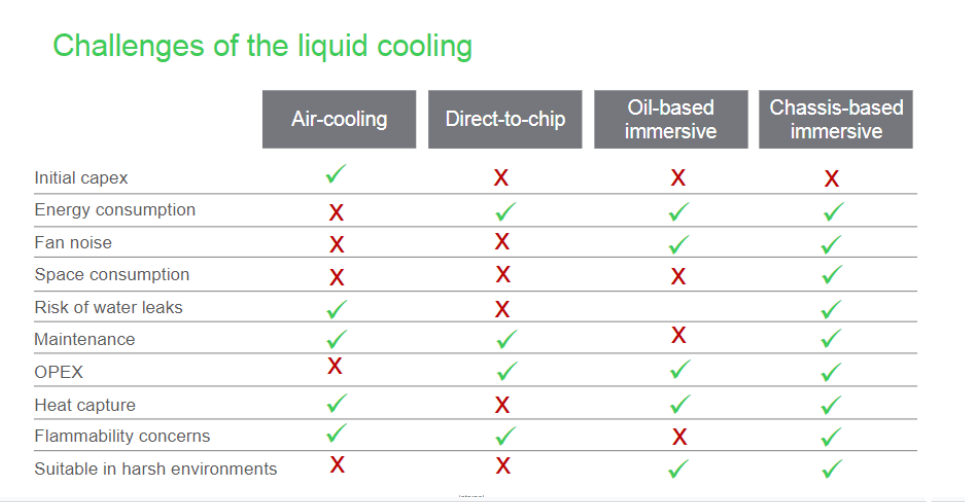

En el camino hacia la sustentabilidad, la refrigeración líquida tiene un gran potencial. Teniendo en consideración que los clientes demandan una mayor densidad por rack, que hay que disipar más calor, además de abordar las densidades de los chips, este enfoque de refrigeración líquida:

- Reduce el consumo de energía

- Elimina el ruido

- Consume menos espacio

- Trabaja en entornos difíciles

- Reduce el uso de agua

Liquid cooling provee importantes ahorros energéticos:

- Una reducción significativa de las pérdidas: 80% de reducción de pérdidas en comparación con el DX (direct expansion) refrigerado por aire

- Ahorro de energía del servidor: 8% de ahorro de energía informática al eliminar los ventiladores

- Ahorro total de energía: hasta un 30% de ahorro total

- Alta eficiencia, independientemente del clima: se puede conseguir un PUE de refrigeración >1,1 en casi cualquier clima

El papel de los sistemas de refrigeración en la sustentabilidad de los Data Centers

Una de las mayores preocupaciones del sector es reducir al máximo el consumo de energía de sus instalaciones, que suele ser altísimo debido a la elevada demanda energética necesaria para refrigerar los Data Centers. En este sentido, los esfuerzos se destinan al ahorro energético, pero también debe ponerse especial cuidado a que la tecnología que se emplea sea lo más amigable con el medio ambiente posible. De hecho, actualmente la sustentabilidad es una de las prioridades del sector y marca la hoja de ruta de todas las estrategias de las compañías y de los sistemas y soluciones que se utilizan.

“La sostenibilidad es clave en cualquier empresa. Los data centers suponen un 5% del consumo total de energía. Si tenemos recursos finitos, tenemos que ser capaces de alinear las capacidades y las necesidades con convivir con la limitación de los recursos. La refrigeración es el agente que más peso tiene en el concepto de eficiencia energética. Es más, representa el mayor porcentaje dentro de la ineficiencia del Data Center, por lo que si tuviésemos que destacar un componente sobre el cual actuar para reducir el consumo energético es claramente este elemento”, señala Pablo Casado de las Heras, Head of Global Data Center & Core Sites de Telefónica.

Otro aspecto importante es el diseño de los sistemas mecánicos: “Son el sistema que más consumo tiene. Sobre todo cuando están mal conceptualizados, tiene que ver con una selección de la ubicación del Data Center, las condiciones locales, condiciones arquitectónicas, de carga, cómo voy a distribuir las cargas de aire”, comenta Arturo Maqueo Bobadilla, Director de Desarrollo de Negocios para México y Centroamérica de Uptime Institute. En este punto, Luiz César Vieyra, Deployment Coordinator de Airsys coincide con Arturo: “Un buen diseño es fundamental para un correcto dimensionamiento del aire. El no hacer bien este punto en muchas empresas les ha afectado incluso al crecimiento de Data Center”. Al anterior punto, Luiz César Vieyra añade la necesidad de planificar y optimizar las operaciones, es decir, una revisión constante de los procedimientos de mantenimiento preventivo con lo que se evitan pérdidas, fugas en las líneas hidráulicas y de refrigeración.

Los expertos explicaron que sería conveniente ir a la sala blanca y hacer un análisis para implementar diversas acciones. Limitar la zona de aire frío y caliente, que no se mezclen, y evitar la recirculación que se pueda producir en el rack mismo. Además, hay que cambiar la filosofía de operación porque normalmente estamos controlando la descarga de los servidores y el retorno de aire caliente: vamos a controlar el suministro de aire frío que sale de los crac. Tomar la recomendación de ASHRAE de llevar una temperatura máxima de 27º entrando al servidor. Hacer free cooling directo e indirecto donde el clima lo permita y emplear sistemas de enfriamiento adiabático, que generan bastante ahorro.

También es conveniente el uso de energía renovable no convencional: paneles fotovoltaicos, eólica y geotérmica. “En Chile existen 8.763 MW de energía renovable no convencional disponible que se está generando”, comenta Jorge Chacano, Ingeniero Senior Mantenimiento Data Center de Entel. A esto, añade: “En Chile existen varias plantas de energía renovable, no convencionales, una de ellas está en el desierto de Atacama, que es capaz de generar 246 MW de energía y 80 se destinan al Data Center de Google ubicado en la región metropolitana. La importancia de que la empresa suscriba estos contratos de energía no convencional supone una inversión adicional que permite desplazar las tecnologías contaminantes como el gas, el diesel o el carbón. La forma de lograr que la demanda de refrigeración de los centros de datos sea más sustentable dependerá en gran medida de dónde se ubiquen y sus condiciones climatológicas. Es preciso un esfuerzo adicional del expertise, interés humano en hacer un Data Center más eficiente y sustentable”. También hace especial hincapié en la aplicación de la inteligencia artificial en la operación de los centros de datos. Integrando más sensores que permitan extraer esa información que se genera en estas infraestructuras y hacer aprendizaje automático que apoye a lograr esta sostenibilidad y eficiencia.

Los 3 imperativos del Data Center

Máxima eficiencia energética, alta eficiencia operativa y alta disponibilidad: permitirán adaptarse a los cambios constantes derivados de las necesidades del mundo de hoy. Proveedores de nube y colocation, hiperescala o Edge: todos los escenarios posibles, no importando el tamaño, requieren de infraestructura más eficiente, donde los sistemas de enfriamiento se han convertido en un foco principal para mejorar el PUE, pero no perdamos de vista que la eficiencia energética debe venir acompañada de una alta disponibilidad y una alta eficiencia operativa.

En relación a la evolución en la reducción del PUE en Latinoamérica, Luis Vázquez, Executive Industry Solution Manager de Huawei, cuenta que Latam está por debajo de la media de ser eficiente. “El Data Center no necesariamente es ineficiente por el mal conocimiento u operación. Influyen elementos externos como la temperatura en Latam y dónde está ubicado el Data Center. También afecta la cantidad y calidad de la energía que llega a nuestros centros de datos. Es una constante en Latam, la calidad no es la óptima y muchas veces tenemos que instalar infraestructuras mucho mayores a las necesidades que tenemos, lo que nos vuelve altamente disponibles pero poco eficientes”, explica.

En relación a la disponibilidad y la eficiencia, Luis Vázquez continúa explicando que gran parte de las fallas o la no disponibilidad del Data Center provienen de los elementos de potencia (UPS), pero también tiene que ver con las baterías de plomo. Por ello, surgen las de litio que brindan mayor disponibilidad y ayudan a ser más eficientes en términos de espacio, consumo energético y de inversión. “Cada componente tiene una tasa de fallas, por lo que el método más confiable es el diseño redundante. Todo el sistema tiene que ser redundante”, agrega.

Respecto al enfriamiento, sabiendo que el aire acondicionado es el sistema que más consume, lo primero que recomienda Luis Vázquez de Huawei es el confinamiento de pasillo frío-caliente para que no se mezclen. “No solo se trata de confinar, es muy importante hacer la implementación de todos los componentes que me ayudarán a ser eficiente. Incluir elementos de monitoreo dentro de los confinamientos: sensores, luminarias, cámaras, que me van a permitir tomar datos en tiempo real de capacidad de los Racks, temperaturas de aire acondicionado en la parte baja y media de los racks. Nos facilitará saber cómo están y tener el algoritmo que me va a permitir operar de manera inteligente y autónoma”, cuenta.

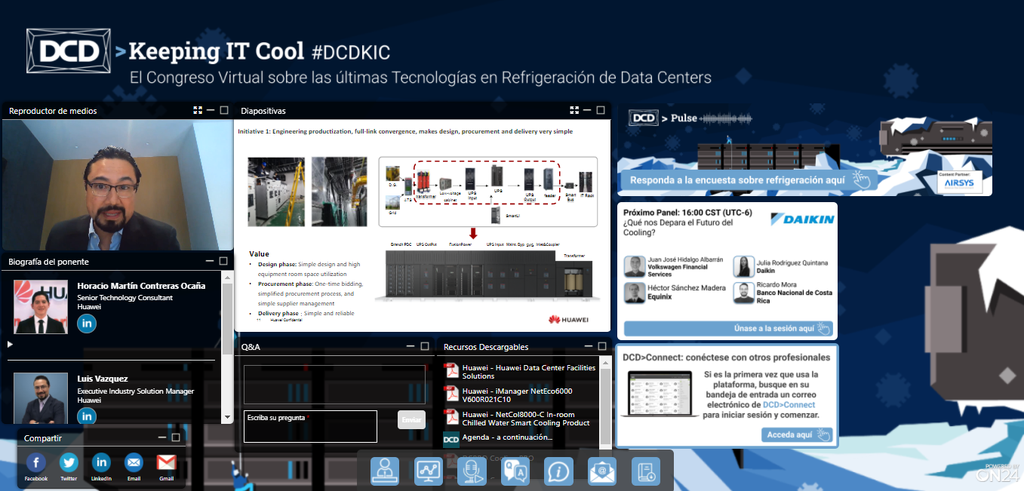

La tecnología es fundamental en el proceso de enfriamiento del Data Center. La inteligencia artificial es utilizada por Huawei para recolectar información que es enviada a su plataforma de DCIM para retroalimentar la inferencia. Tal y como explica Horacio Martín Contreras Ocaña, Senior Technology Consultant de Huawei, hay dos etapas: primero se alimenta y entrena la herramienta con la información para entender cómo funciona el sistema de enfriamiento y la inferencia ayuda a saber qué es lo que sigue, ya que con esos datos se tratará de predecir qué es lo que va a suceder, por lo que se pueden hacer ajustes en los elementos de enfriamiento para ahorrar energía y agua.

¿Hacia dónde va el futuro del cooling?

La innovación y el cambio constante forman parte de la vida útil de los Data Centers, puesto que las necesidades de estas infraestructuras críticas varían en función de sus densidades, requerimientos de eficiencia y fiabilidad, sustentabilidad o seguridad, entre otros. Dependiendo del tipo de centro de datos y de sus exigencias se adopta un enfoque diferente en las estrategias de refrigeración.

Julia Rodríguez Quintana, Consulting Sales Director de Daikin, comenta que: “Lo que vemos en el futuro son el free cooling, los compresores de velocidad variable, los ventiladores de los condensadores, el desarrollo de nuevos refrigerantes, entre otros. Estos desarrollos en las tecnologías no solo tienen beneficios en los consumos de energía, sino también en el ruido y la confiabilidad de la operación del Data Center. Esto en conjunto con la adecuada gestión del sistema va a garantizar que la operación sea óptima y permite maximizar la eficiencia de acuerdo a la condiciones de operación y a las condiciones ambientales. En resumen, la sostenibilidad y la automatización engloban el futuro para la refrigeración de Data Centers”.

Héctor Sánchez Madera, Senior Manager, Facility Operations de Equinix explica que es una conjunción de las necesidades de hoy y futuras y siempre el objetivo va a ser mantener las condiciones ambientales y de operación adecuadas para los equipos alojados en el Data Center. En cuanto a las nuevas estrategias de climatización que empiezan a adoptar los Data Centers apunta a varias:

- Adaptarse a las condiciones de temperatura recomendadas para los equipos de TI controlando la temperatura del pasillo frío o de entrada a los equipos

- Eficiencia energética, equipos con mayor relación, con sistemas de aprovechamiento de recursos, enfriamiento adiabático y free cooling

- Recursos disponibles y equipos a utilizar: componentes con avances tecnológicos que van desde válvulas de expansión electrónica, compresores de levitación magnética libres de aceites o el uso de variadores de velocidad.

- Equipos con una mayor relación de capacidad de enfriamiento y espacio requerido para hacer un uso eficiente del mismo dentro del Data Center. El espacio es valioso, cuanto más espacio tengamos para vender, más eficiente será financieramente.

- Versatilidad de los controladores de los equipos de aire acondicionado. Equipos preconfigurados, trabajo de los equipos en red, control por retorno o inyección, la posibilidad de instalar sensores adicionales en los racks, la notificación remota de alarmas y supervisión de procesos.

- Cambio del enfriamiento convencional por aire al líquido, ya sea por inmersión en 1-2 fases o directo al chip de los servidores.

En cuanto a los desafíos que tenemos por delante cuando hablamos de refrigeración, Ricardo Mora, Data Center Manager del Banco Nacional de Costa Rica, señala que uno de ellos está relacionado con brindar continuidad al proceso de enfriamiento y esto debido a la demanda de crecimiento que se pueda presentar. “Es importante que los sistemas de refrigeración de los Data Centers nos puedan ofrecer la continuidad necesaria. Cuando hablamos del futuro nos dicen que necesitamos aplicar cambios, pero tienen que ser muy controlados en un ambiente en el cual analizar y medir el impacto que puede tener el proceso de adaptación. Además, se vuelve un punto medular el acompañamiento que tengan las empresas (proveedores de enfriamiento) porque juegan un papel importante en la gestión y administración y mantenimiento del cambio”.

Por otro lado, Ricardo Mora continúa explicando que tecnologías como IA, IoT y 5G también impactarán en la refrigeración de los Data Centers:

- Estas tecnologías pueden aportar al desempeño que pueden tener las soluciones de refrigeración. La IA puede mejorar el funcionamiento de las máquinas, hacer análisis de telemetrías, sugerir cambios y optimizar el proceso de climatización. También puede minimizar la probabilidad de errores por la manipulación de personas. Con la IA tenemos la posibilidad de manejar de manera más automática las configuraciones, los equipos y las instalaciones.

- Todas estas tecnologías producen y aumentan las capacidades de trasiego de datos y este crecimiento repercute en soluciones de almacenamiento y procesamiento. Por lo que el Data Center necesitará albergar y dar sostenibilidad y continuidad a todos estos sistemas de almacenamiento y procesamiento.

Sobre las nuevas tecnologías que marcarán tendencia en la refrigeración de Data Centers habló Juan José Hidalgo Albarrán, Head of Network and Data Center México de Volkswagen Financial Services. “Van a ser aquellas que reduzcan la huella de carbono, optimicen el consumo energético y permiten variabilidad y escalabilidad, es decir, conforme va creciendo el Data Center, poder incluir sistemas de enfriamiento que me permitan no aumentar mi consumo de energía, seguir siendo amable con el medio ambiente y que los gastos no sean excesivos. Racks enfriados por inmersión, inyección directa será muy adoptado porque no requiere de grandes inversiones para enfriar una sala de 15-20 metros cuadrados. Permitirán a compañías de cualquier tamaño adoptar estas tecnologías”, ejemplifica.

El futuro de la refrigeración es sustentable. Sin embargo, requiere el esfuerzo de todos los jugadores de la industria de Data Centers; de la gestión y el monitoreo de un todo (no solo de los enfriadores, manejadores); de la planificación y optimización, tener mantenimientos programados, de hacer correcciones en los sistemas; y del uso de la energía renovable para reducir la huella de carbono.